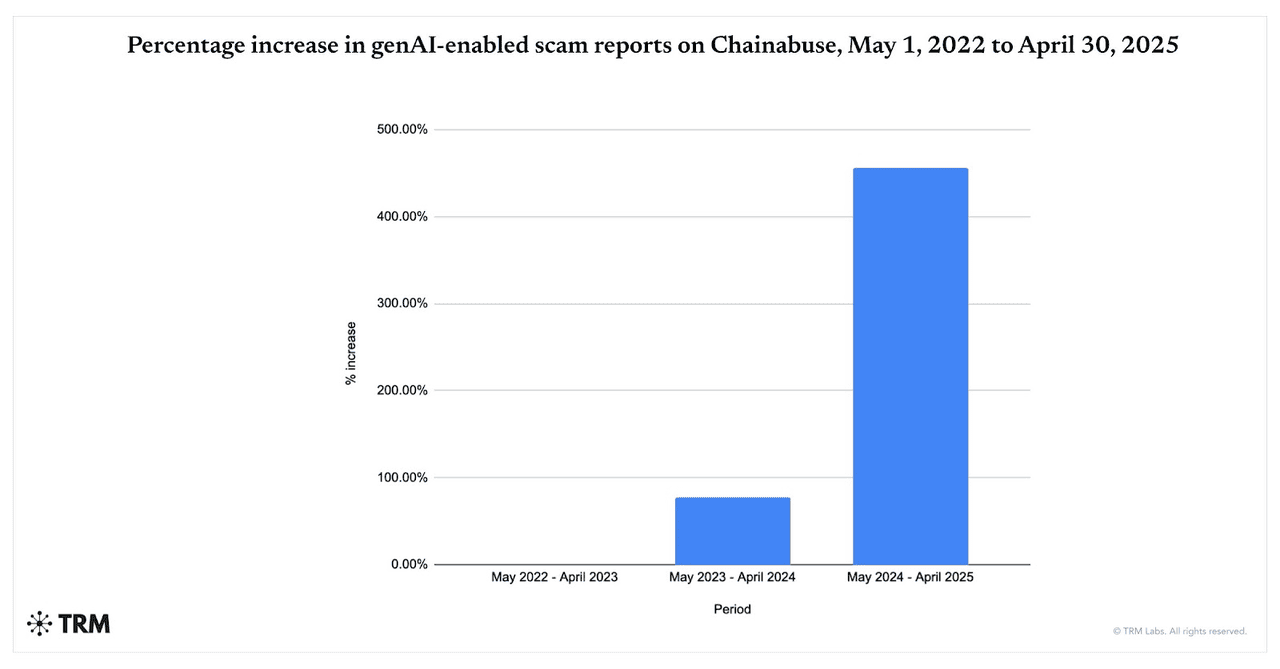

Escrocheriile alimentate de AI se accelerează. Între mai 2024 și aprilie 2025, rapoartele de escrocherii activate de gen-AI au crescut cu 456%, conform datelor Chainabuse de la TRM Labs. Chainalysis descoperă de asemenea că 60% din depozitele în portofelele de escrocherie provin acum din escrocherii care utilizează instrumente AI, în creștere abruptă față de 2024, subliniind cât de larg adoptă fraudatorii LLM-urile, deepfake-urile și automatizarea.

Creșterea escrocheriilor generate de AI din 2022 până în 2025 | Sursă: TRM Labs

Ce determină creșterea escrocheriilor crypto alimentate de AI în 2025? AI oferă viteză, scală și realism: un operator poate crea mii de momeli de phishing personalizate, videoclipuri/voci deepfake și imitări de branduri în minute, conținut care evită filtrele vechi și convinge victimele. Din noiembrie 2025, noi suprafețe de atac precum injectarea de prompt împotriva browserelor agentice și copiloților AI au crescut riscul ca paginile web rău intente sau capturile de ecran să poată detourna asistenții conectați la portofele sau conturi.

Și crypto rămâne o țintă primară: piețele în mișcare rapidă, tranzacțiile ireversibile și decontarea on-chain 24/7 fac recuperarea dificilă, în timp ce tendințele mai largi ale criminalității din 2025, de la hack-uri la pig-butchering, arată că riscul general al ecosistemului crypto crește.

În acest ghid, veți învăța ce sunt escrocheriile crypto AI, cum funcționează și cum să rămâneți în siguranță când utilizați platformele de tranzacționare, inclusiv BingX.

Ce Sunt Escrocheriile Crypto Alimentate de AI și Cum Funcționează?

Escrocheriile crypto alimentate de AI folosesc tehnici avansate de

inteligență artificială pentru a vă înșela, furând banii, cheile private sau acreditările de autentificare. Aceste escrocherii depășesc cu mult

schemele de phishing din vechiul stil. Sunt mai inteligente, mai rapide și mult mai credibile ca niciodată.

Frauda crypto tradițională implica de obicei tactici manuale: email-uri prost scrise, campanii generice pe rețelele sociale sau imitări evidente. Acelea erau mai ușor de observat dacă știai ce să cauți.

Escrocheriile crypto activate de AI cresc într-un ritm exploziv. TRM Labs raportează o creștere de 456% a activității de escrocherie AI generativă între mai 2024 și aprilie 2025, în timp ce Chainalysis descoperă că aproximativ 60% din toate depozitele în portofelele de escrocherie provin acum din operațiuni care folosesc instrumente AI. În paralel, The Defiant notează că escrocheriile crypto conduse de AI au crescut cu aproape 200% an la an din mai 2025, arătând cât de rapid adoptă fraudatorii deepfake-urile, boții automatizați și phishing-ul generat de AI pentru a viza utilizatorii la scară largă.

Dar acum AI schimbă jocul. Fraudatorii valorifică AI generativ, boți de învățare automată, clonarea vocii și videoclipuri deepfake pentru a:

1. Crea Conținut Realist și Personalizat Care Se Simte Uman

Instrumentele AI pot genera email-uri de phishing și mesaje false care sună și se citesc ca și cum ar fi venit de la un prieten de încredere, influencer sau platformă. Folosesc gramatică perfectă, imită tiparele de vorbire și chiar inserează detalii personale bazate pe comportamentul dvs. online. Videoclipurile deepfake și clonele vocale împing acest lucru mai departe: ați putea cu adevărat crede că un CEO, celebritate sau cunoștință vă vorbește.

2. Lansează Atacuri Masive cu Viteza Fulgerului

Cu AI generativ și modele lingvistice mari (LLM), escrocii pot produce mii de mesaje de phishing, site-uri web false sau boți de imitare în secunde. Aceste mesaje pot fi localizate, personalizate, distribuite prin email, Telegram, Discord, SMS și rețelele sociale. Ceea ce înainte necesita echipe dedicate poate fi acum făcut de un singur operator cu instrumentele potrivite.

3. Ocolește Filtrele Tradiționale și Sistemele de Securitate

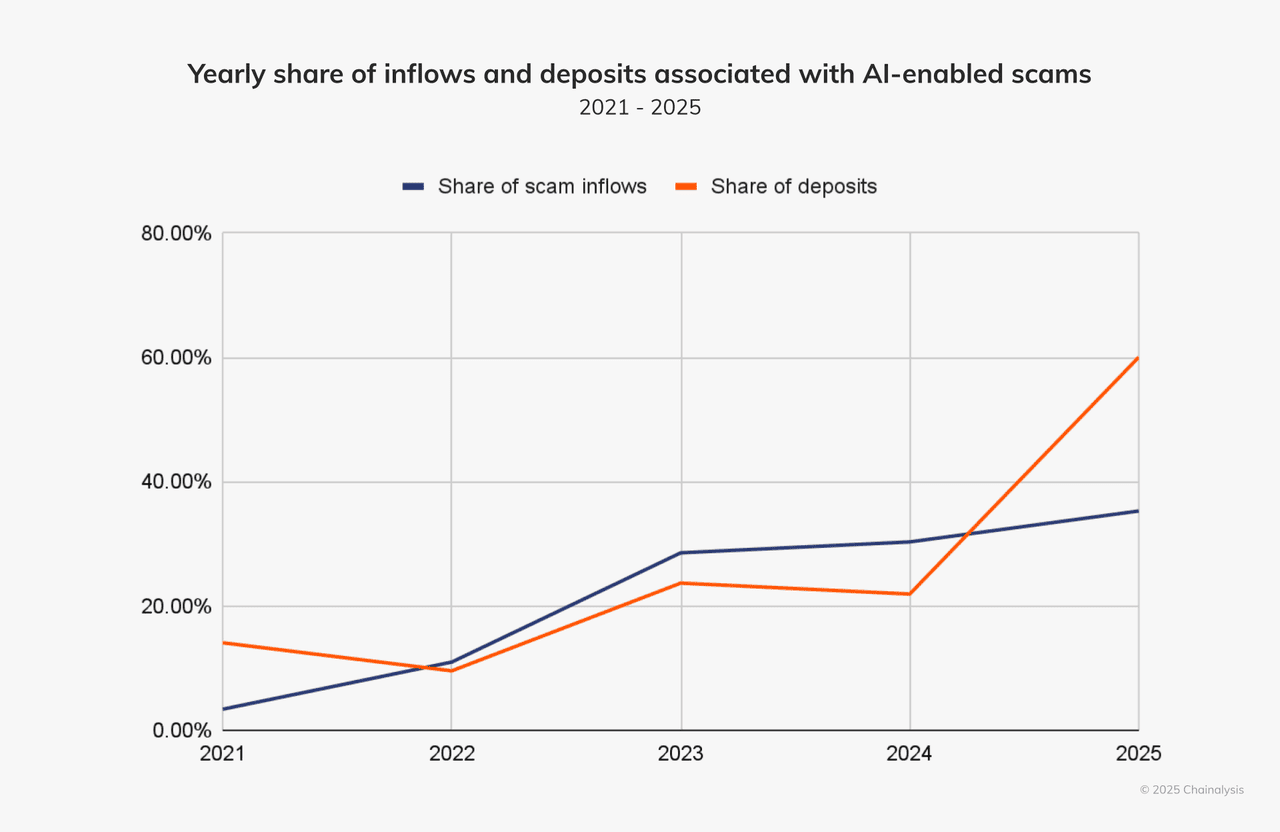

Sistemele mai vechi de detectare a fraudei căutau greșeli de ortografie, indicii evidente de inginerie socială, domenii refolosite. Escrocheriile alimentate de AI evită aceste capcane. Generează conținut curat, rotesc domeniile, folosesc caractere invizibile/de lățime zero, imită comportamentul uman și combină canalele, cum ar fi vocea, videoclipul și chat-ul. Conform firmei de analiză Chainalysis, aproximativ 60% din toate depozitele în portofelele de escrocherie provin acum din escrocherii care valorifică instrumentele AI.

Influxurile și depozitele din escrocheriile AI sunt în creștere | Sursă: Chainalysis

Aceste atacuri sunt mai convingătoare tocmai pentru că imită modul în care se comportă, vorbesc și scriu oamenii reali. Sunt mai ușor de scalat și mai greu de detectat. De exemplu: folosind un instrument precum WormGPT sau FraudGPT, un atacator poate lansa mii de escrocherii foarte credibile în minute.

De Ce Este Crypto o Țintă Ideală pentru Escrocheriile AI?

Piața crypto este deosebit de vulnerabilă la această nouă generație de escrocherii: tranzacțiile sunt rapide, adesea ireversibile, iar utilizatorii sunt frecvent în afara cadrelor tradiționale de reglementare sau protecție a consumatorilor. Adăugați o audiență globală, multiple canale precum social, chat, forumuri și declanșatori emoționali/de lăcomie ridicate, de ex., „dublează-ți crypto", „

airdrop exclusiv", „endorsul CEO", și aveți un mediu în care escrocii alimentați de AI prosperă.

Care Sunt Tipurile Comune de Escrocherii Crypto Conduse de AI?

Escrocheriile crypto alimentate de AI combină acum deepfake-uri, modele lingvistice mari (LLM) și automatizare pentru a imita oamenii, a produce în masă phishing și a ocoli filtrele vechi. Să explorăm tipurile cele mai comune și cazurile din lumea reală care arată cât de periculoase au devenit.

1. Escrocherii Deepfake: Imitarea Audio și Video

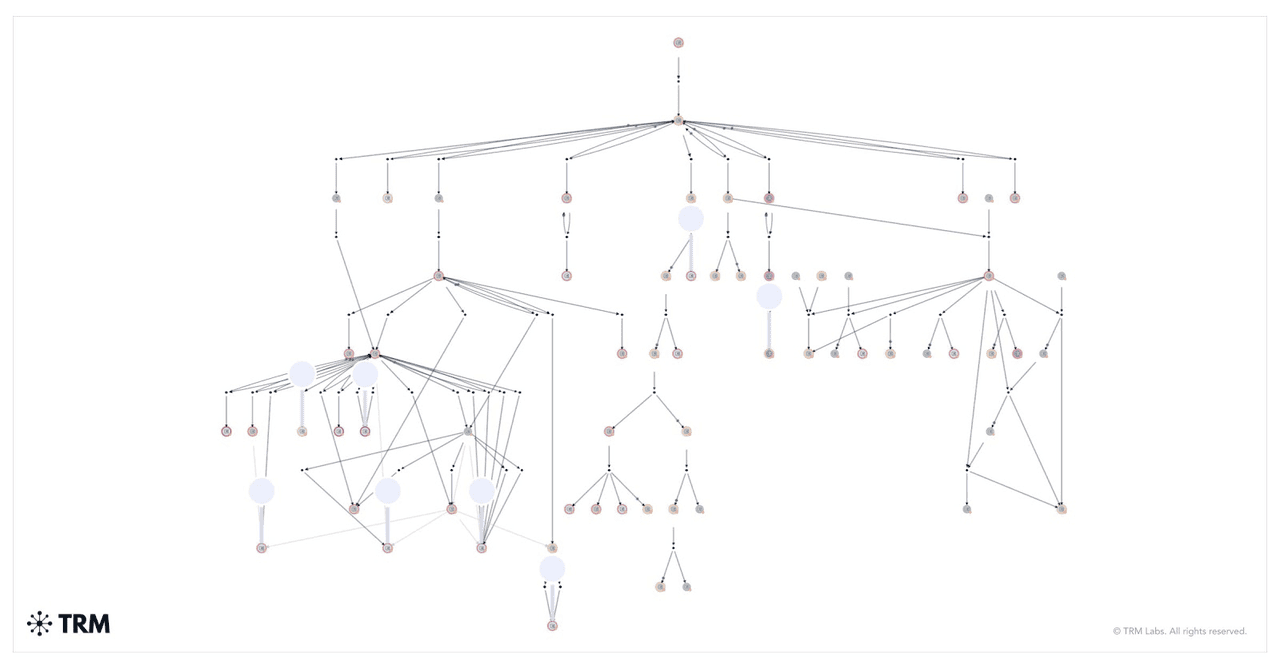

Cum au fost mutate fondurile dintr-o escrocherie de giveaway deepfake | Sursă: TRM Labs

Escrocheriile deepfake folosesc videoclipuri sau clipuri audio generate de AI pentru a imita figuri publice, influenceri sau chiar executivi din propria dvs. companie. Escrocii manipulează expresiile faciale și tiparele vocale pentru a face conținutul să pară real. Aceste videoclipuri false promovează adesea giveaway-uri crypto frauduloase sau vă instruiesc să trimiteți fonduri la adrese specifice de portofele.

Unul dintre cele mai alarmante cazuri s-a întâmplat la începutul lui 2024. Un angajat din finanțe la o companie multinațională din Hong Kong s-a alăturat unui apel video cu ceea ce părea a fi CFO-ul companiei și executivii seniori. L-au instruit să transfere 25 de milioane de dolari. A fost o capcană. Apelul a fost un deepfake, iar fiecare față și voce au fost generate de AI. Angajatul nu a știut până când a fost prea târziu.

Aceeași tactică este folosită pentru a imita lideri tech precum Elon Musk. Într-o escrocherie, videoclipuri deepfake ale lui Musk au promovat un giveaway

Bitcoin. Spectatorii au fost instruiți să trimită

BTC la un

portofel și să primească înapoi dublul sumei. Chainalysis a urmărit un singur portofel care a colectat milioane de dolari în timpul unui livestream fals pe YouTube.

2. Phishing Generat de AI

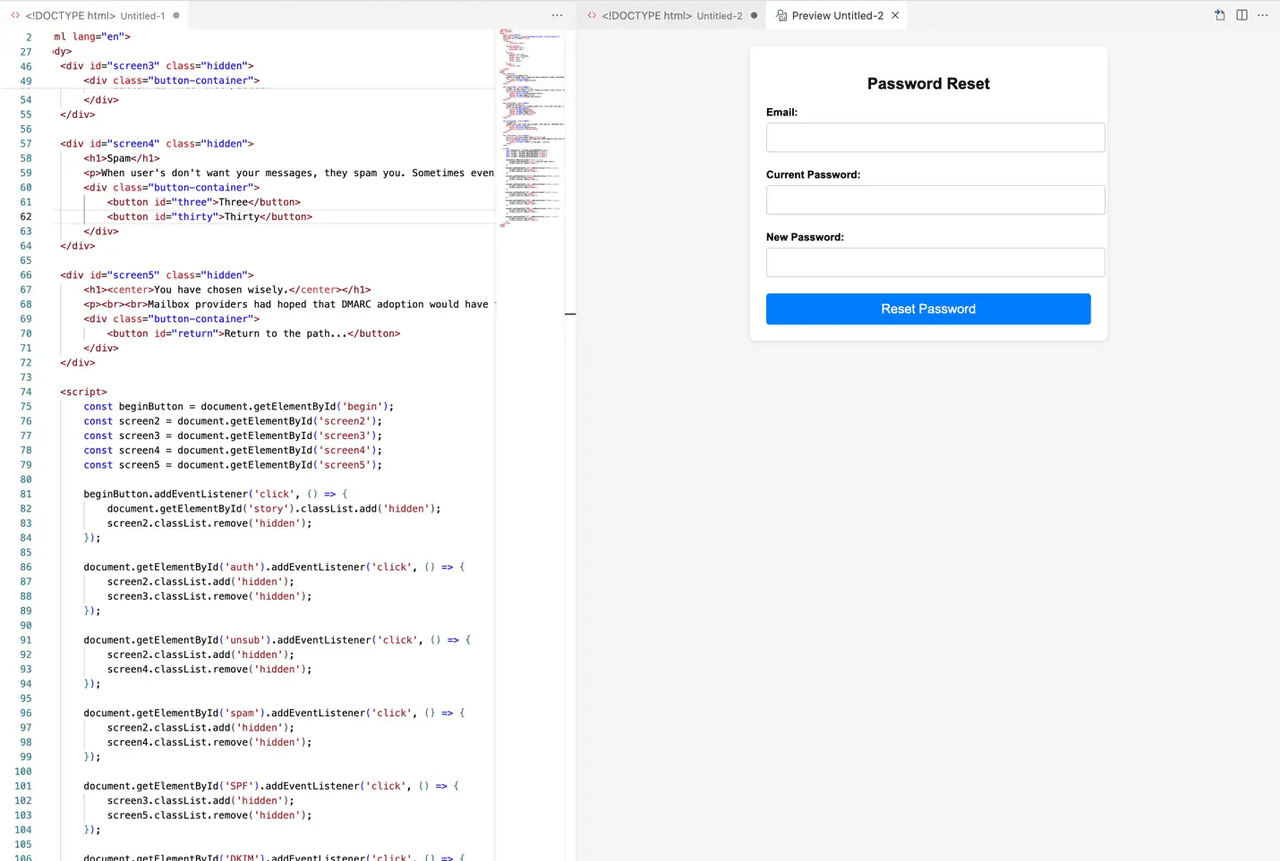

Exemplu de site web de phishing generat de AI | Sursă: MailGun

Phishing-ul a evoluat cu AI. În loc de gramatică neglijentă și link-uri suspecte, aceste mesaje par reale și se simt personale. Escrocii folosesc AI pentru a colecta date publice despre dvs., apoi creează email-uri, DM-uri sau chiar site-uri web complete care se potrivesc intereselor și comportamentului dvs.

Escrocheria poate veni prin Telegram, Discord, email sau chiar LinkedIn. Ați putea primi un mesaj care imită

suportul BingX, îndemnându-vă să „verificați contul" sau să „revendicați o recompensă". Link-ul duce la o pagină falsă care arată aproape identic cu cea reală. Introduceți informațiile dvs. și jocul s-a terminat.

TRM Labs a raportat o creștere de 456% a tentativelor de phishing generate de AI într-un singur an. Aceste atacuri folosesc acum modele lingvistice mari (LLM) pentru a imita tonul uman și a se adapta la diferite limbi. Unii escroci chiar folosesc AI pentru a ocoli verificările

KYC, a genera acreditări false sau a simula chat-uri live cu „agenți de suport".

3. Platforme și Boți de Tranzacționare AI Falși

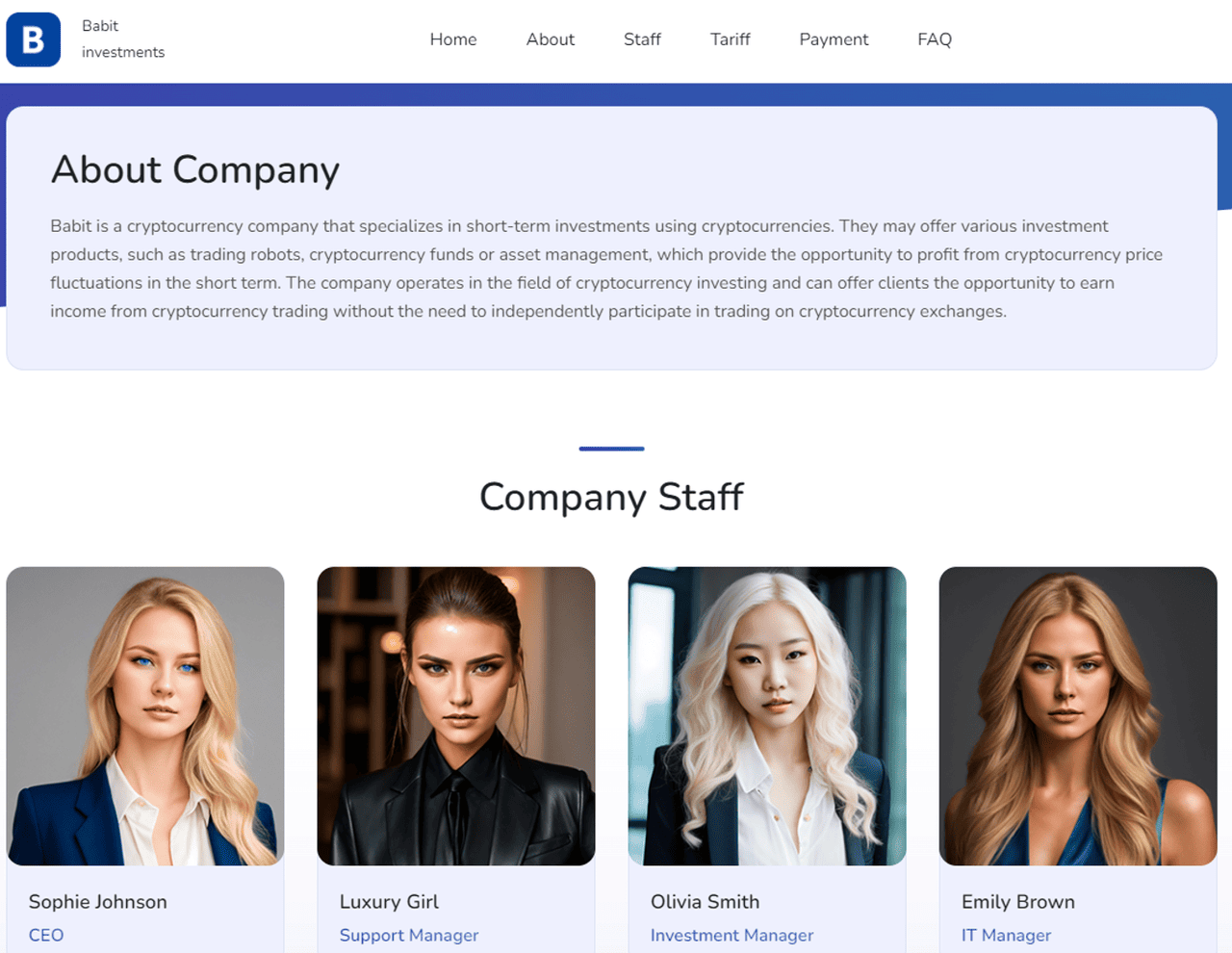

Cum a folosit MetaMax AI pentru a crea o companie falsă cu angajați falși | Sursă: TRM Labs

Escrocii construiesc de asemenea platforme de tranzacționare întregi care pretind că folosesc AI pentru profituri automate. Aceste instrumente false promit randamente garantate, execuția „inteligentă" a tranzacțiilor sau rate de succes imbatabile. Dar odată ce depozitați crypto-ul dvs., dispare.

Aceste escrocherii par adesea legitime. Prezintă dashboard-uri elegante, grafice live și mărturii, toate alimentate de imagini și cod generate de AI. Unele oferă chiar tranzacții demo pentru a falsifica performanța. În 2024, site-uri precum MetaMax au folosit avataruri AI de CEO-i falși pentru a câștiga încredere și a atrage utilizatori nimic bănuitori.

În realitate, nu există nicio strategie alimentată de AI în spatele acestor platforme, doar o capcană bine concepută. Odată ce fondurile intră, veți descoperi că nu puteți retrage nimic. Unii utilizatori raportează că portofelele lor sunt golite după conectarea la aceste site-uri. Boții AI trimit de asemenea „semnale" pe Telegram sau Twitter pentru a vă împinge spre tranzacții riscante sau inexistente.

4. Clonarea Vocii și Apelurile în Timp Real

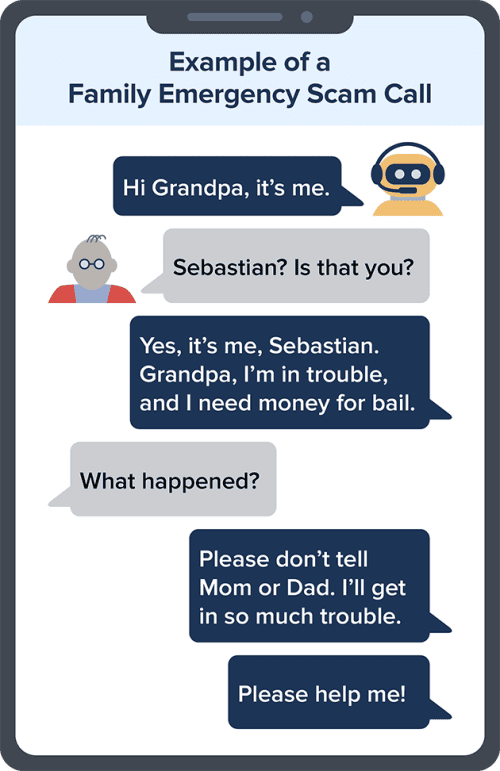

Exemplu de escrocherie de clonare vocală AI | Sursă: FTC

Clonarea vocală AI face posibil pentru escroci să sune exact precum cineva pe care îl cunoașteți. Pot recrea vocea unui CEO, a managerului dvs. sau chiar a unui membru de familie, apoi vă sună cu instrucțiuni urgente să trimiteți crypto sau să aprobați o tranzacție.

Această tehnică a fost folosită în jaful de 25 de milioane de dolari din Hong Kong menționat anterior. Angajatul nu a fost doar înșelat de videoclipul deepfake; atacatorii au clonat de asemenea vocile în timp real pentru a sigila înșelăciunea. Doar câteva secunde de audio sunt suficiente pentru ca escrocii să recreeze vocea cuiva cu o acuratețe șocantă.

Aceste apeluri vin adesea în timpul orelor libere sau urgențelor. Ați putea auzi ceva precum: „Hei, sunt eu. Contul nostru este înghețat. Am nevoie să trimiți

USDT acum." Dacă vocea sună familiară și cererea este urgentă, s-ar putea să nu o puneți la îndoială, mai ales dacă numărul pare legitim.

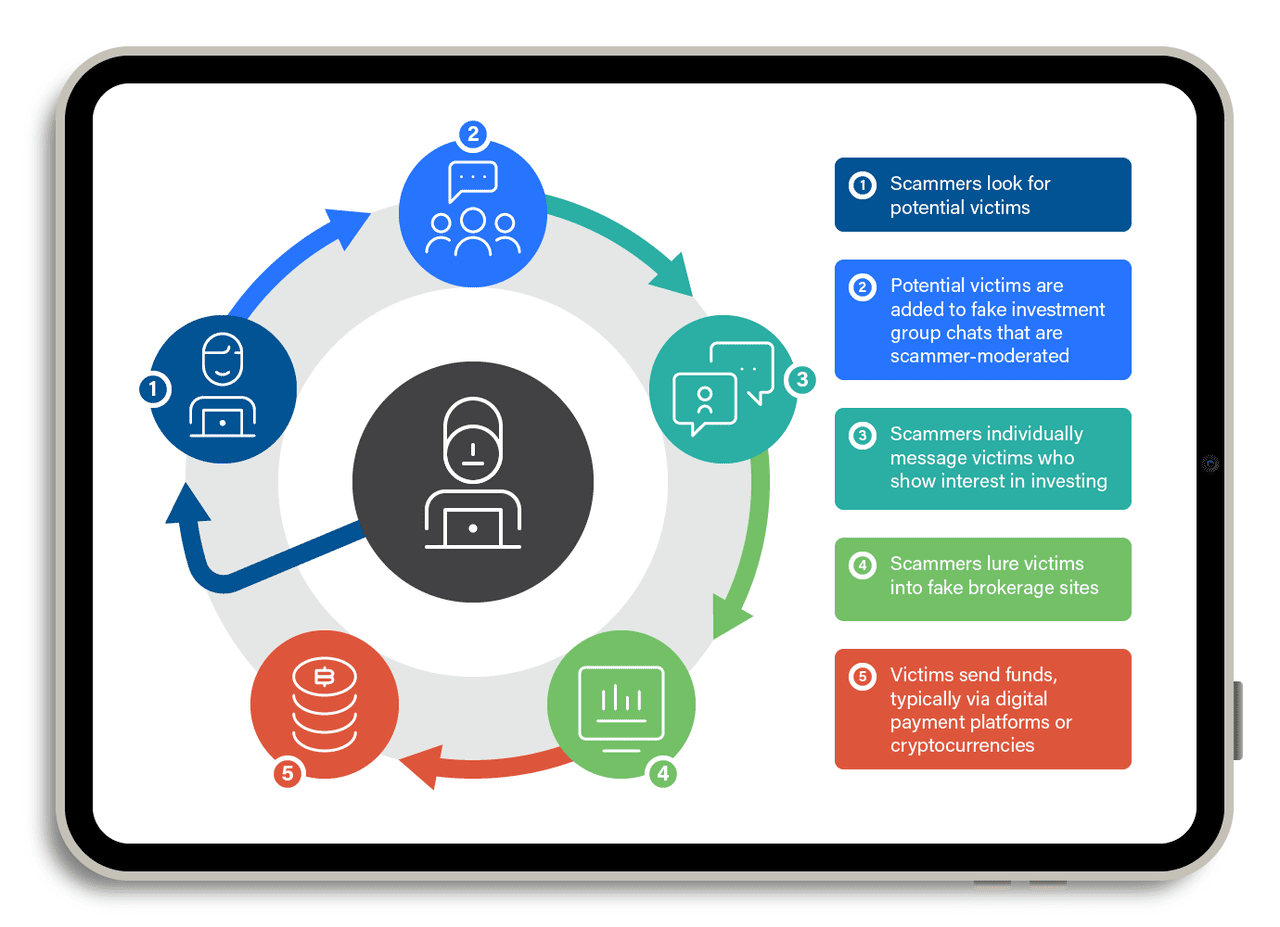

5. Pig-Butchering cu AI

Cum funcționează o escrocherie pig-butchering | Sursă: TrendMicro

Escrocheriile „pig butchering" sunt escrocherii pe termen lung. Implică construirea încrederii în timp, poate săptămâni sau chiar luni. Escrocii se prefac a fi un interes romantic sau partener de afaceri, folosind adesea aplicații de întâlniri, Telegram sau WeChat. Odată ce câștigă încrederea dvs., vă conving să investiți într-o platformă crypto falsă.

Acum, folosesc chatboți AI pentru a scala această strategie. Acești boți dețin conversații naturale, fluide. Urmăresc regulat, răspund la întrebările dvs. și chiar oferă sfaturi de viață. Totul este scris, dar se simte real.

În 2024, Chainalysis a raportat că escrocheriile pig-butchering asistate de AI au adus peste 9,9 miliarde de dolari la nivel global. Unii escroci folosesc chiar deepfake-uri pentru apeluri video, arătând o față prietenoasă care pare umană. Victimele depozitează sume mici, văd câștiguri false și apoi investesc mai mult, până când site-ul dispare sau retragerile sunt blocate.

Toate aceste escrocherii se bazează pe un singur lucru: încrederea dvs. Prin imitarea oamenilor reali, platformelor și echipelor de suport, instrumentele AI fac mai dificilă distingerea între ce este real și ce este fals. Dar odată ce știți cum funcționează aceste escrocherii, sunteți mult mai bine pregătiți să le opriți. Rămâneți vigilenți și nu lăsați AI să vă ia crypto-ul.

6. Injectarea de Prompt Împotriva Browserelor Agentice și AI-urilor Conectate la Portofele

O nouă amenințare în 2025 implică injectarea de prompt, unde un site web, imagine sau text rău intenționat „deturnează" un agent AI conectat la un browser, email sau chiar un portofel crypto. Pentru că unii browsere AI și copiloții de portofele pot citi date, rezuma pagini sau întreprinde acțiuni în numele unui utilizator, o instrucțiune ascunsă poate forța agentul să dezvăluie informații private sau să inițieze tranzacții nesigure.

Cercetătorii de securitate citați de Elliptic și multiple bloguri din industrie avertizează că acest risc crește pe măsură ce mai multe AI-uri obțin permisiuni legate de fonduri. De exemplu, un prompt poate instrui AI-ul să „trimită active doar la <portofelul atacatorului>", însemnând că orice tranzacție viitoare rutată prin agent ar putea fi deviată fără ca utilizatorul să observe. Deoarece utilizatorii au adesea încredere în AI să „automatizeze" sarcinile, această suprafață de atac crește mai repede decât phishing-ul tradițional și este mai greu de detectat pentru că nimic nu „pare" suspect pentru victima umană.

7. Ocolirea KYC și ID-uri False la Schimburi și VASP-uri

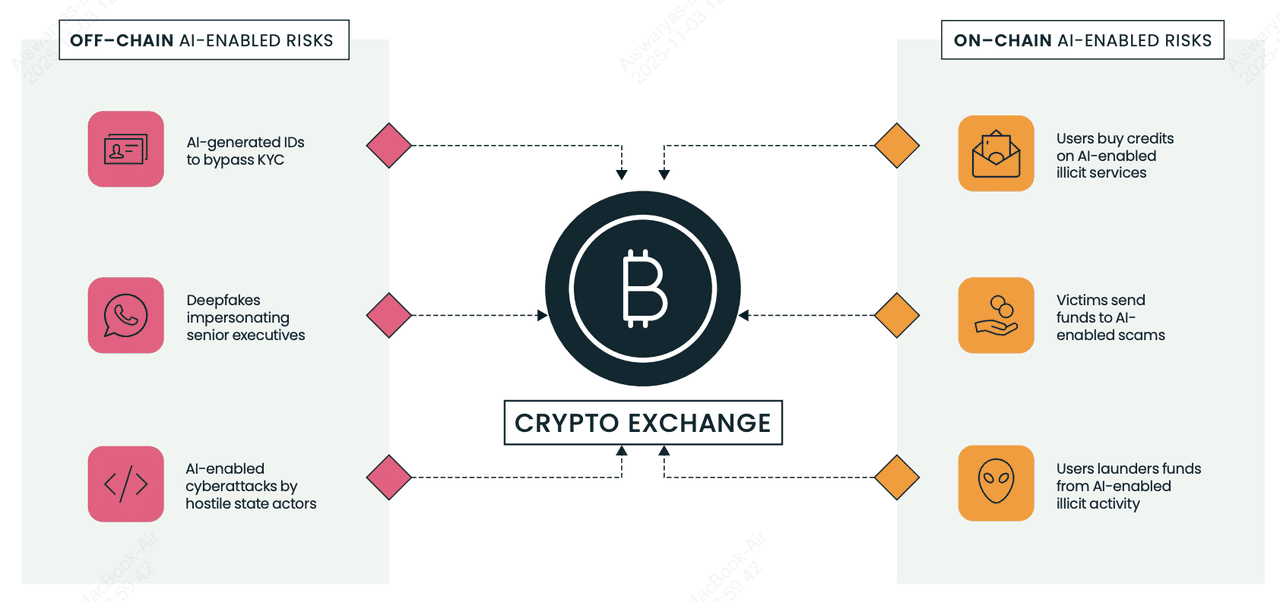

Riscuri legate de AI on-chain și off-chain pentru schimburile crypto și VASP-uri | Sursă: Elliptic

Grupurile de fraudatori folosesc acum selfie-uri, pașapoarte și permise de conducere generate de AI pentru a ocoli verificările KYC la schimburile crypto (

VASP-uri) și a deschide conturi de catâr pentru spălarea fondurilor furate.

Raportul de Tipologii 2025 al Elliptic evidențiază piețe care vând ID-uri false îmbunătățite cu AI și kituri de selfie „face-swap" care pot trece verificarea automatizată dacă o platformă nu are detectare avansată. Odată aprobați, criminalii mută crypto-ul furat prin aceste conturi în „tranzacții de test" mici, apoi escaladează activitatea la transferuri mai mari, adesea către adrese pe care instrumentele de analiză le semnalează ca fiind de risc ridicat.

Semnalele de alarmă includ inconsistențe minore în documentele de identitate, creșteri bruște de volum după crearea contului și conexiuni neexplicate la portofele legate anterior de escrocherii. Pentru începători, acest lucru contează pentru că chiar și platformele legitime pot fi abuzate în fundal, iar schimburile se bazează acum pe analiza blockchain pentru a îngheța sau urmări fondurile înainte să dispară.

8. Botnets Sociale pe X (Twitter)

Escrocii crypto operează botnets masive pe X care par umane, răspund instantaneu la postări și împing link-uri de golire a portofelelor sau airdrop-uri false. Conform analiștilor de securitate citați de Chainalysis și media din industrie, AI face acești boți mai greu de observat, fără text repetat, gramatică mai bună, argou localizat, chiar răspunsuri personalizate. O tactică comună numită „reply-and-block" face ca boții să răspundă utilizatorilor reali (amplificând semnalele de angajament), apoi îi blochează, ceea ce poate reduce vizibilitatea victimei în timp ce amplificază postările de escrocherie.

Aceste rețele imită adesea fondatori, influenceri sau suportul schimburilor, apoi momesc utilizatorii să semneze contracte inteligente rău intenționate. Pentru că utilizatorii crypto se bazează pe X pentru știri în timp real, boții exploatează urgența și frica de a pierde. Pentru începători: nu aveți niciodată încredere în link-urile din răspunsuri, mai ales dacă promit token-uri gratuite, randamente garantate sau necesită aprobări de portofele; majoritatea „giveaway-urilor" de profil înalt pe X sunt escrocherii.

Cum să Vă Apărați de Escrocheriile AI

Escrocheriile AI devin mai inteligente, dar puteți rămâne cu un pas înaintea lor. Urmați aceste sfaturi pentru a vă proteja crypto-ul și liniștea sufletească.

1. Activați 2FA, Passkeys sau o Cheie Hardware: Autentificarea cu doi factori (2FA) blochează majoritatea tentativelor de preluare a contului pentru că escrocii au nevoie de mai mult decât parola dvs. Studiile de securitate cibernetică precum Raportul de Securitate Google arată că breșele de conturi scad cu peste 90% când 2FA bazată pe hardware este activată. Dacă platforma dvs. suportă

Passkeys, activați-le; ele înlocuiesc parolele în întregime cu o autentificare criptografică legată de dispozitivul dvs., făcând atacurile de phishing aproape inutile pentru că nu există parolă de furat. Instrumente precum

Google Authenticator, Passkeys incorporate pe iOS/Android sau un YubiKey fac aproape imposibil pentru atacatori să se conecteze, chiar dacă vă înșală cu email-uri de phishing generate de AI. Activați întotdeauna 2FA sau Passkeys pe BingX, email, schimburi și portofele care le suportă.

2. Verificați Link-urile și URL-urile cu Atenție: O mare parte din escrocheriile AI încep cu un link fals. Chainalysis notează că site-urile web de phishing generate de AI sunt unul dintre vectorii de escrocherie cu cea mai rapidă creștere pentru că arată aproape identic cu platformele reale. Înainte de a face clic, treceți cu mouse-ul pentru a previzualiza URL-ul și asigurați-vă că se potrivește cu domeniul oficial BingX. Marcați pagina de autentificare și evitați link-urile trimise prin email, Telegram, Discord sau răspunsuri Twitter; escrocii imită adesea conturile de suport sau paginile de airdrop pentru a fura autentificări și informații de portofele.

3. Fiți Sceptici față de Orice Sună Prea Bine: Dacă un bot pretinde „randamente garantate", „venit fără risc" sau „dublează-ți crypto-ul", este o escrocherie. Tranzacționarea reală, chiar și cu AI, nu garantează niciodată profitul. Chainalysis a raportat că platformele de tranzacționare false și „boții de semnale AI" au furat miliarde în 2024-25 prin promiterea de randamente pe care niciun sistem real nu le poate livra. Dacă ceva sună prea bine pentru a fi adevărat în crypto, întotdeauna este.

4. Nu Împărtășiți Niciodată Frazele Seed sau Cheile Private: Fraza dvs. seed controlează portofelul. Oricine vă cere aceasta încearcă să vă fure crypto-ul. Niciun schimb, proiect sau echipă de suport legitimă nu o va solicita, nici măcar o dată. Multe escrocherii de phishing conduse de AI cer acum utilizatorilor să „verifice" portofelul sau să „deblocheze recompense bonus" folosind o frază seed. În momentul în care o tastați într-un site web fals, activele dvs. au dispărut. Tratați fraza seed ca identitatea dvs. digitală: privată, offline și niciodată împărtășită.

5. Folosiți Doar Suportul Oficial BingX: Escrocii imită frecvent agenții de suport ai schimburilor prin email sau rețelele sociale. Vor pretinde că există o problemă cu retragerea dvs. sau vor oferi „asistență" pentru a remedia o problemă de cont — apoi vă trimit un link rău intenționat. Accesați întotdeauna suportul prin site-ul web oficial BingX sau aplicație. Dacă cineva vă contactează primul, presupuneți că este o escrocherie. Elliptic și TRM Labs notează că atacurile de imitare au crescut brusc pe măsură ce instrumentele AI fac conturile false mai greu de distins de cele reale.

6. Stocați Crypto-ul pe Termen Lung într-un Portofel Hardware: Portofelele hardware precum Ledger și Trezor păstrează cheile dvs. private offline, ceea ce vă protejează fondurile chiar dacă cădeți în capcana unui link de phishing sau atac de malware. Pentru că dispozitivul trebuie să aprobe fizic fiecare tranzacție, escrocii nu vă pot fura crypto-ul de la distanță. Cercetările din multiple audituri de securitate crypto arată că stocarea la rece rămâne cea mai eficientă metodă de a proteja deținerile pe termen lung, mai ales când piețele sunt vizate de golitorii de portofele conduși de AI.

7. Rămâneți Informați cu Resursele de Învățare BingX: Escrocheriile AI evoluează rapid, iar a rămâne educat este una dintre cele mai puternice apărări. TRM Labs a găsit o creștere de 456% a escrocheriilor activate de AI an la an, ceea ce înseamnă că noi tactici apar constant. Citirea ghidurilor de securitate de încredere, alertelor de escrocherie și avertismentelor de phishing vă ajută să observați semnalele de alarmă înainte să deveniți victimă.

Academia BingX publică regulat sfaturi de siguranță prietenoase pentru începători, astfel încât utilizatorii să poată tranzacționa cu încredere chiar și într-un mediu în schimbare rapidă.

Concluzie și Puncte Cheie

Escrocheriile crypto alimentate de AI se răspândesc pentru că sunt ieftine, scalabile și convingătoare, dar puteți încă să rămâneți în siguranță. Activați 2FA, evitați să faceți clic pe link-uri neverificate, stocați fondurile pe termen lung într-un portofel hardware și nu împărtășiți niciodată fraza seed. Dacă cineva promite profituri garantate sau vă trimite un link suspect, plecați. Și pe măsură ce escrocii evoluează, cea mai bună apărare a dvs. este cunoașterea. Urmăriți Academia BingX pentru sfaturi continue de securitate, alerte de escrocherie și educație de siguranță crypto, astfel încât să vă puteți proteja activele în era AI.

Lecturi Aferente