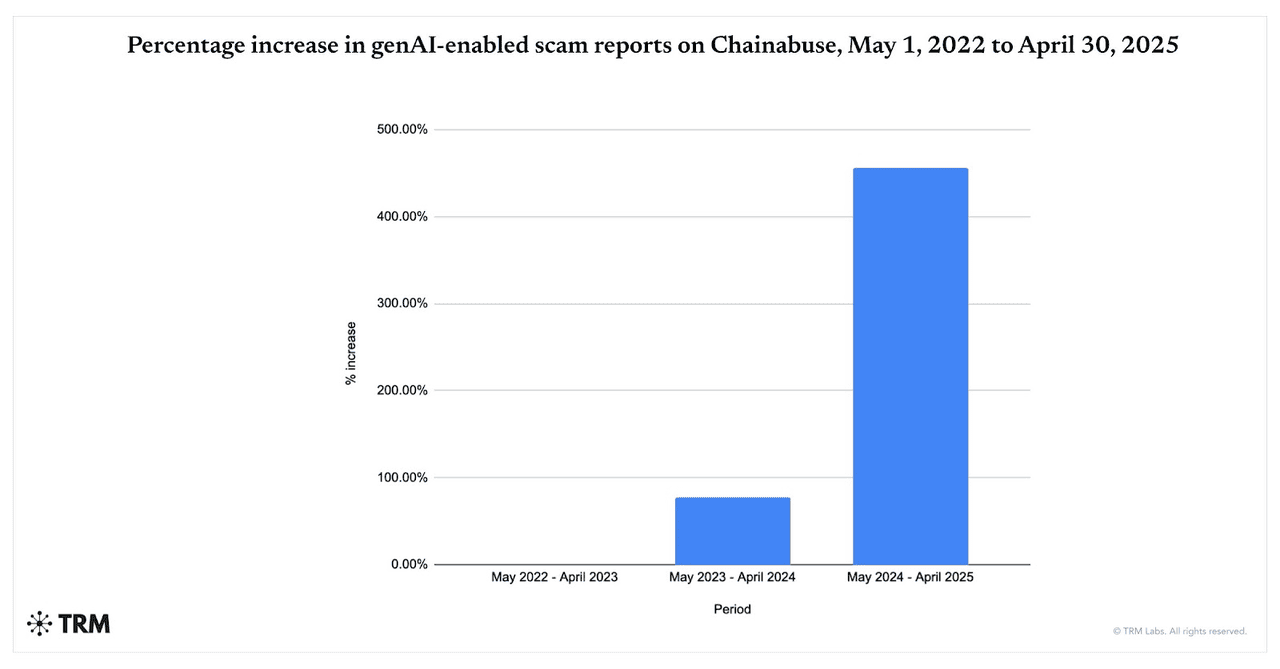

Os golpes alimentados por IA estão acelerando. Entre maio de 2024 e abril de 2025, os relatórios de golpes habilitados por IA generativa saltaram 456%, segundo os dados do Chainabuse da TRM Labs. A Chainalysis também descobriu que 60% dos depósitos em carteiras de golpes agora fluem para golpes que aproveitam ferramentas de IA, uma alta acentuada em relação a 2024, destacando como os fraudadores estão adotando amplamente LLMs, deepfakes e automação.

Golpes habilitados por IA aumentam de 2022 a 2025 | Fonte: TRM Labs

O que está impulsionando o aumento nos golpes cripto alimentados por IA em 2025? A IA oferece velocidade, escala e realismo: um operador pode criar milhares de iscas de phishing personalizadas, vídeos/vozes deepfake e imitações de marca em minutos, conteúdo que escapa de filtros legados e convence vítimas. A partir de novembro de 2025, novas superfícies de ataque como injeção de prompt contra navegadores agênticos e copilotos de IA aumentaram o risco de que páginas web maliciosas ou capturas de tela possam sequestrar assistentes conectados a carteiras ou contas.

E as criptomoedas permanecem um alvo principal: mercados em movimento rápido, transações irreversíveis e liquidação on-chain 24/7 tornam a recuperação difícil, enquanto tendências de crime mais amplas de 2025, de hacks a pig-butchering, mostram o risco geral do ecossistema cripto aumentando.

Neste guia, você aprenderá o que são golpes cripto de IA, como funcionam e como se manter seguro ao usar plataformas de trading, incluindo a BingX.

O Que São Golpes Cripto Alimentados por IA e Como Funcionam?

Golpes cripto alimentados por IA usam técnicas avançadas de

inteligência artificial para enganar você, roubando seu dinheiro, chaves privadas ou credenciais de login. Esses golpes vão muito além dos antigos

esquemas de phishing. Eles são mais inteligentes, mais rápidos e muito mais convincentes do que nunca.

A fraude cripto tradicional tipicamente envolvia táticas manuais: e-mails mal escritos, sorteios genéricos de mídia social ou imitação óbvia. Esses eram mais fáceis de detectar se você soubesse o que procurar.

Golpes cripto habilitados por IA estão crescendo em um ritmo explosivo. A TRM Labs relata um aumento de 456% na atividade de golpes de IA generativa entre maio de 2024 e abril de 2025, enquanto a Chainalysis descobriu que cerca de 60% de todos os depósitos em carteiras de golpes agora vêm de operações usando ferramentas de IA. Paralelamente, o The Defiant observa que golpes cripto impulsionados por IA cresceram quase 200% ano a ano a partir de maio de 2025, mostrando como rapidamente os fraudadores estão adotando deepfakes, bots automatizados e phishing gerado por IA para atingir usuários em escala.

Mas agora a IA muda o jogo. Fraudadores estão aproveitando IA generativa, bots de machine learning, clonagem de voz e vídeo deepfake para:

1. Criar Conteúdo Realista e Personalizado Que Parece Humano

Ferramentas de IA podem gerar e-mails de phishing e mensagens falsas que soam e parecem ter vindo de um amigo de confiança, influenciador ou plataforma. Eles usam gramática perfeita, imitam padrões de fala e até inserem toques pessoais baseados no seu comportamento online. Vídeos deepfake e clones de voz levam isso adiante: você pode genuinamente acreditar que um CEO, celebridade ou conhecido está falando com você.

2. Lançar Ataques Massivos em Velocidade Relâmpago

Com IA generativa e grandes modelos de linguagem (LLMs), golpistas podem produzir milhares de mensagens de phishing, sites falsos ou bots de imitação em segundos. Essas mensagens podem ser localizadas, personalizadas, distribuídas por e-mail, Telegram, Discord, SMS e mídia social. O que antes exigia equipes dedicadas agora pode ser feito por um único operador com as ferramentas certas.

3. Contornar Filtros Tradicionais e Sistemas de Segurança

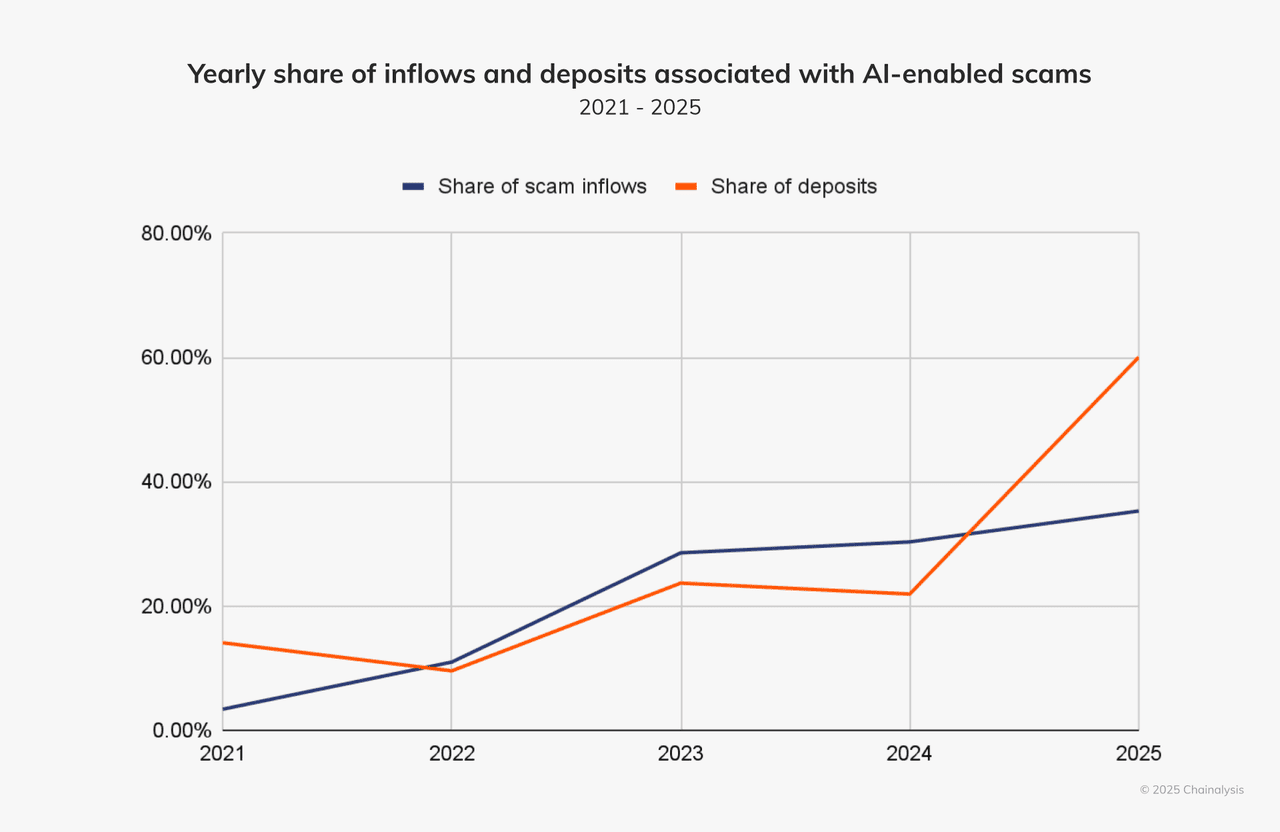

Sistemas de detecção de fraude mais antigos procuravam erros de ortografia, pistas óbvias de engenharia social, domínios reutilizados. Golpes alimentados por IA evitam essas armadilhas. Eles geram texto limpo, alternam domínios, usam caracteres invisíveis/de largura zero, imitam comportamento humano e combinam canais, como voz, vídeo e chat. Segundo a empresa de análise Chainalysis, cerca de 60% de todos os depósitos em carteiras de golpes agora fluem para golpes que aproveitam ferramentas de IA.

Entradas e depósitos de golpes de IA estão em alta | Fonte: Chainalysis

Esses ataques são mais convincentes precisamente porque imitam como pessoas reais se comportam, falam e escrevem. Eles são mais fáceis de escalar e mais difíceis de detectar. Por exemplo: usando uma ferramenta como WormGPT ou FraudGPT, um atacante pode lançar milhares de golpes muito credíveis em minutos.

Por Que Cripto É um Alvo Ideal para Golpes de IA?

O mercado cripto é especialmente vulnerável a essa nova geração de golpes: transações são rápidas, frequentemente irreversíveis, e usuários estão frequentemente fora de estruturas regulatórias tradicionais ou de proteção ao consumidor. Adicione uma audiência global, múltiplos canais como social, chat, fóruns e gatilhos de alta emoção/ganância, ex., "dobre sua cripto", "

airdrop exclusivo", "endosso de CEO", e você tem um ambiente onde golpistas alimentados por IA prosperam.

Quais São os Tipos Comuns de Golpes Cripto Impulsionados por IA?

Golpes cripto alimentados por IA agora misturam deepfakes, grandes modelos de linguagem (LLMs) e automação para personificar pessoas, produzir phishing em massa e contornar filtros legados. Vamos explorar os tipos mais comuns e casos do mundo real que mostram como perigosos eles se tornaram.

1. Golpes Deepfake: Imitação de Áudio e Vídeo

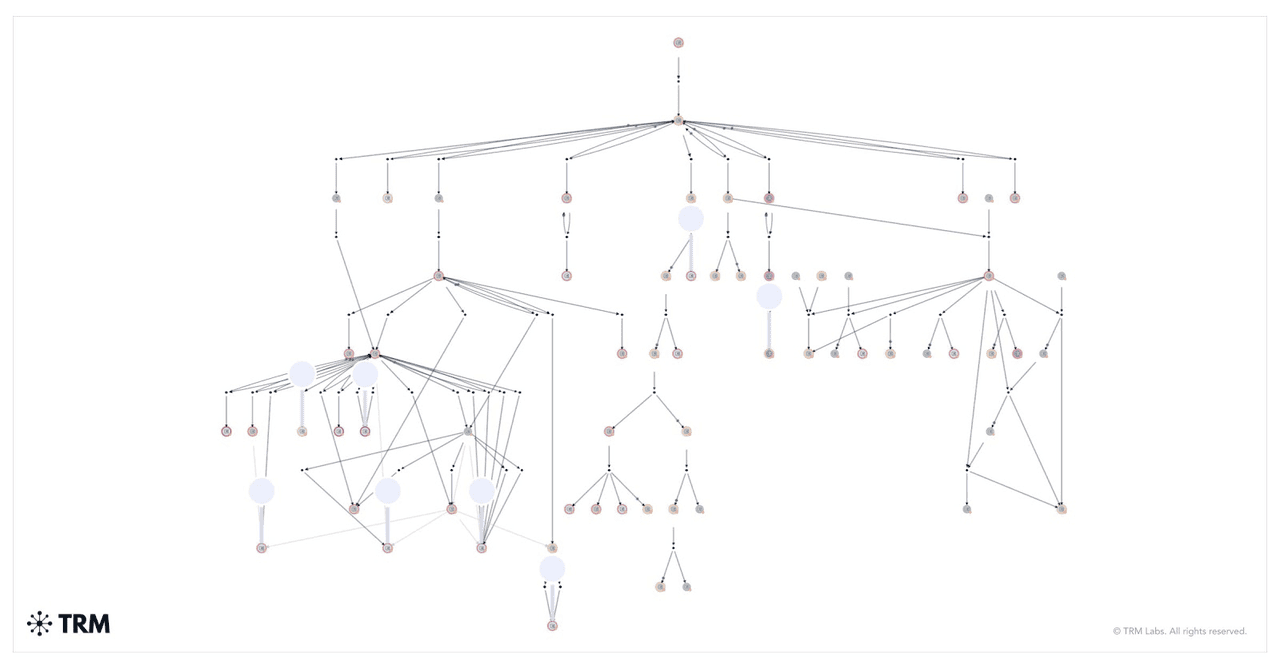

Como os fundos de um golpe de sorteio deepfake foram movidos | Fonte: TRM Labs

Golpes deepfake usam vídeos ou clipes de áudio gerados por IA para personificar figuras públicas, influenciadores ou até executivos da sua própria empresa. Golpistas manipulam expressões faciais e padrões de voz para fazer o conteúdo parecer real. Esses vídeos falsos frequentemente promovem sorteios cripto fraudulentos ou instruem você a enviar fundos para endereços de carteira específicos.

Um dos casos mais alarmantes aconteceu no início de 2024. Um funcionário financeiro de uma empresa multinacional em Hong Kong participou de uma videochamada com o que parecia ser o CFO da empresa e executivos seniores. Eles instruíram ele a transferir $25 milhões. Era uma armadilha. A chamada era um deepfake, e cada rosto e voz foi gerado por IA. O funcionário não soube até ser tarde demais.

Essa mesma tática está sendo usada para personificar líderes tecnológicos como Elon Musk. Em um golpe, vídeos deepfake de Musk promoveram um sorteio de

Bitcoin. Espectadores foram instruídos a enviar

BTC para uma

carteira e receber o dobro de volta. A Chainalysis rastreou uma única carteira que coletou milhões de dólares durante uma transmissão ao vivo falsa no YouTube.

2. Phishing Gerado por IA

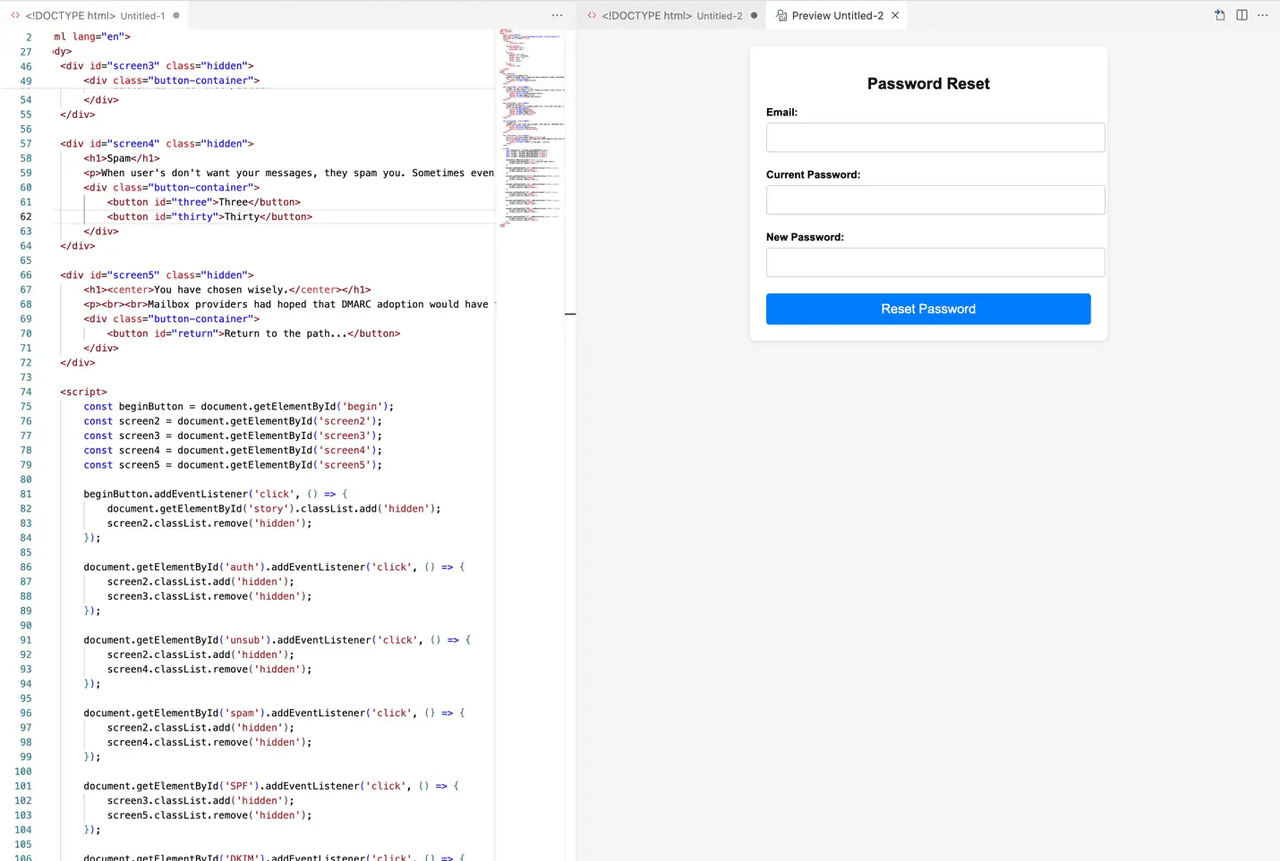

Exemplo de um site de phishing gerado por IA | Fonte: MailGun

Phishing evoluiu com IA. Em vez de gramática desleixada e links suspeitos, essas mensagens parecem reais e se sentem pessoais. Golpistas usam IA para coletar dados públicos sobre você, então criam e-mails, DMs ou até sites completos que combinam com seus interesses e comportamento.

O golpe pode vir através do Telegram, Discord, e-mail ou até LinkedIn. Você pode receber uma mensagem que imita o

suporte da BingX, urgindo você a "verificar sua conta" ou "reivindicar uma recompensa". O link leva a uma página falsa que parece quase idêntica à real. Digite suas informações, e acabou.

A TRM Labs relatou um aumento de 456% em tentativas de phishing geradas por IA em apenas um ano. Esses ataques agora usam grandes modelos de linguagem (LLMs) para imitar tom humano e se adaptar a diferentes idiomas. Alguns golpistas até usam IA para contornar verificações

KYC, gerar credenciais falsas ou simular chats ao vivo com "agentes de suporte".

3. Plataformas e Bots de Trading de IA Falsos

Como a MetaMax usou IA para criar uma empresa falsa com funcionários falsos | Fonte: TRM Labs

Golpistas também constroem plataformas de trading inteiras que afirmam usar IA para lucros automáticos. Essas ferramentas falsas prometem retornos garantidos, execução "inteligente" de trades ou taxas de sucesso imbatíveis. Mas uma vez que você deposita sua cripto, ela desaparece.

Esses golpes frequentemente parecem legítimos. Eles apresentam painéis elegantes, gráficos ao vivo e depoimentos, todos alimentados por imagens e código gerados por IA. Alguns até oferecem trades demo para falsificar desempenho. Em 2024, sites como MetaMax usaram avatares de IA de CEOs falsos para ganhar confiança e atrair usuários desavisados.

Na realidade, não há estratégia alimentada por IA por trás dessas plataformas, apenas uma armadilha bem projetada. Uma vez que os fundos entram, você descobrirá que não pode retirar nada. Alguns usuários relatam suas carteiras sendo drenadas após conectá-las a esses sites. Bots de IA também enviam "sinais" no Telegram ou Twitter para empurrá-lo em direção a trades arriscados ou inexistentes.

4. Clonagem de Voz e Chamadas em Tempo Real

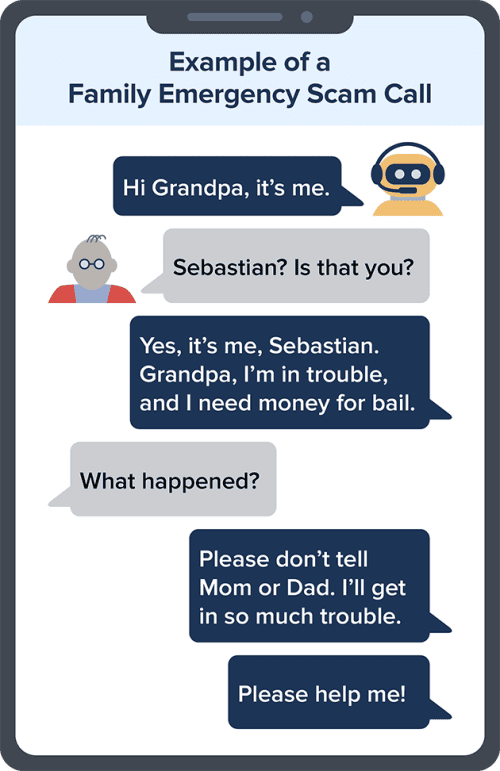

Exemplo de um golpe de clonagem de voz por IA | Fonte: FTC

A clonagem de voz por IA torna possível para golpistas soarem exatamente como alguém que você conhece. Eles podem recriar a voz de um CEO, do seu gerente ou até de um membro da família, então ligar para você com instruções urgentes para enviar cripto ou aprovar uma transação.

Esta técnica foi usada no roubo de $25 milhões de Hong Kong mencionado anteriormente. O funcionário não foi apenas enganado por vídeo deepfake; os atacantes também clonaram vozes em tempo real para selar o engano. Apenas alguns segundos de áudio são suficientes para golpistas recriarem a voz de alguém com precisão chocante.

Essas chamadas frequentemente vêm durante horas de folga ou emergências. Você pode ouvir algo como: "Ei, sou eu. Nossa conta está congelada. Preciso que você envie

USDT agora". Se a voz soar familiar e a solicitação for urgente, você pode não questionar, especialmente se o número parecer legítimo.

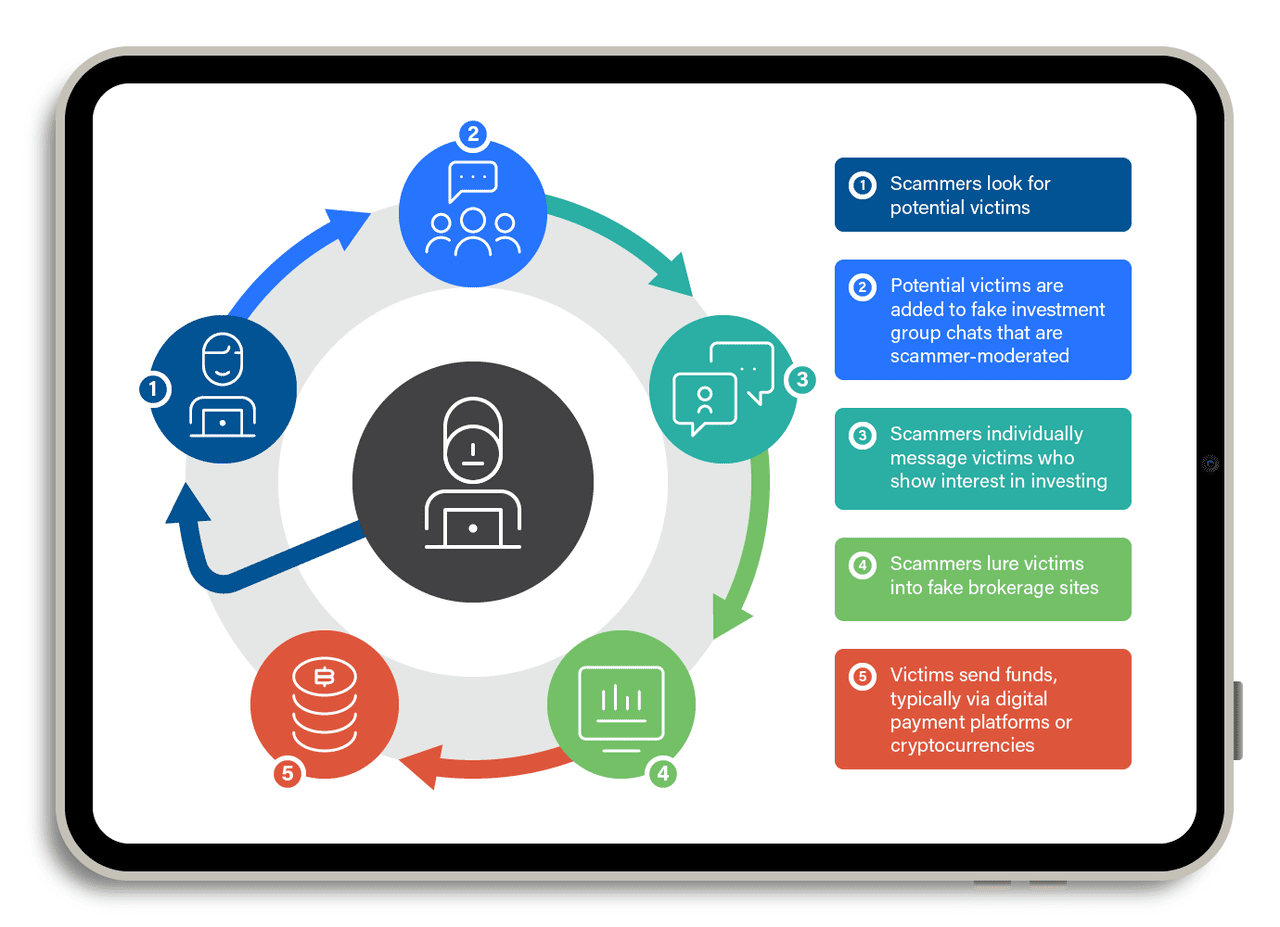

5. Pig-Butchering com IA

Como um golpe de pig-butchering funciona | Fonte: TrendMicro

Golpes de "pig butchering" são golpes longos. Eles envolvem construir confiança ao longo do tempo, talvez semanas ou até meses. Golpistas fingem ser um interesse romântico ou parceiro de negócios, frequentemente usando aplicativos de namoro, Telegram ou WeChat. Uma vez que ganham sua confiança, eles convencem você a investir em uma plataforma cripto falsa.

Agora, eles estão usando chatbots de IA para escalar essa estratégia. Esses bots mantêm conversas naturais e fluidas. Eles fazem acompanhamento regular, respondem suas perguntas e até oferecem conselhos de vida. É tudo roteirizado, mas parece real.

Em 2024, a Chainalysis relatou que golpes de pig-butchering assistidos por IA trouxeram mais de $9,9 bilhões globalmente. Alguns golpistas até usam deepfakes para videochamadas, mostrando um rosto amigável que paece humano. Vítimas depositam pequenas quantias, veem ganhos falsos e então investem mais, até o site desaparecer ou saques serem bloqueados.

Esses golpes todos dependem de uma coisa: sua confiança. Ao imitar pessoas reais, plataformas e equipes de suporte, ferramentas de IA tornam mais difícil distinguir o que é real do que é falso. Mas uma vez que você sabe como esses golpes funcionam, você está muito melhor preparado para pará-los. Fique alerta, e não deixe a IA pegar sua cripto.

6. Injeção de Prompt Contra Navegadores Agênticos e IAs Conectadas a Carteiras

Uma nova ameaça em 2025 envolve injeção de prompt, onde um site malicioso, imagem ou texto "sequestra" um agente de IA conectado a um navegador, e-mail ou até uma carteira cripto. Como alguns navegadores de IA e copilotos de carteira podem ler dados, resumir páginas ou tomar ações em nome do usuário, uma instrução oculta pode forçar o agente a vazar informações privadas ou iniciar transações inseguras.

Pesquisadores de segurança citados pela Elliptic e múltiplos blogs da indústria alertam que esse risco aumenta à medida que mais IAs ganham permissões vinculadas a fundos. Por exemplo, um prompt pode instruir a IA a "enviar ativos apenas para <carteira do atacante>", significando que qualquer transação futura roteada através do agente pode ser desviada sem o usuário perceber. Como usuários frequentemente confiam na IA para "automatizar" tarefas, essa superfície de ataque está crescendo mais rápido que phishing tradicional e é mais difícil de detectar porque nada "parece" suspeito para a vítima humana.

7. Contorno de KYC e IDs Falsas em Exchanges e VASPs

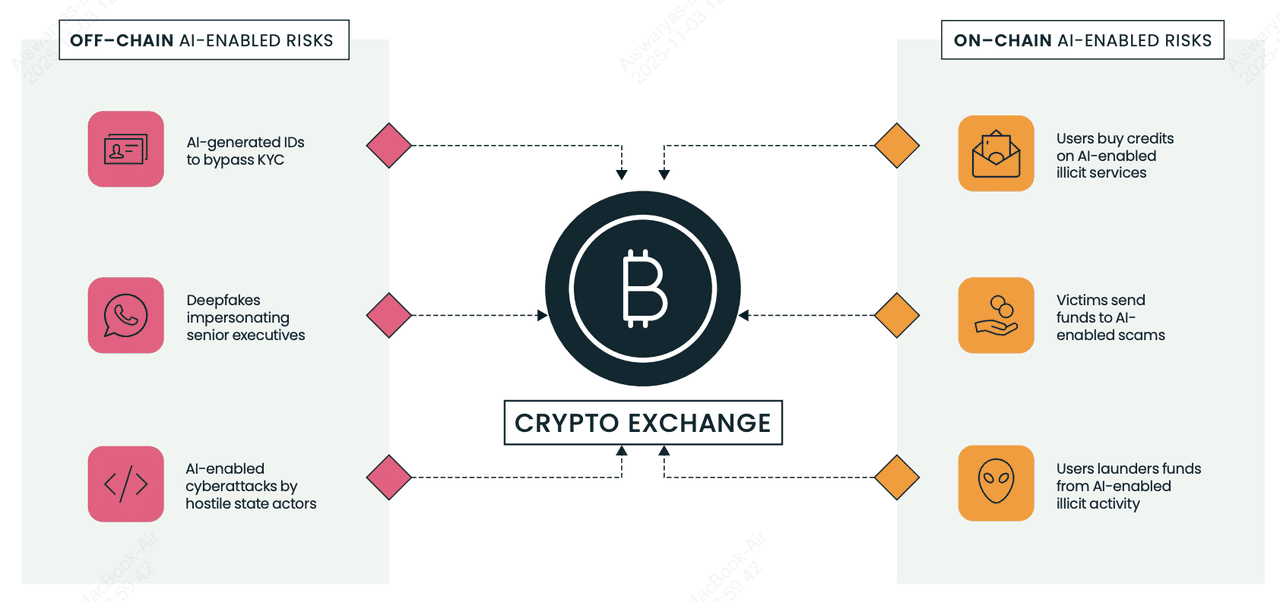

Riscos relacionados à IA on-chain e off-chain para exchanges cripto e VASPs | Fonte: Elliptic

Grupos de fraude agora usam selfies, passaportes e carteiras de motorista geradas por IA para contornar verificações KYC em exchanges cripto (

VASPs) e abrir contas de mula para lavar fundos roubados. O

Relatório de Tipologias 2025 da Elliptic destaca mercados vendendo IDs falsas aprimoradas por IA e kits de selfie "troca de rosto" que podem passar por verificação automatizada se uma plataforma carecer de detecção avançada. Uma vez aprovados, criminosos movem cripto roubada através dessas contas em pequenas "transações de teste", então escalonam a atividade para transferências maiores, frequentemente para endereços que ferramentas de análise sinalizam como alto risco.

Sinais de alerta incluem inconsistências menores entre documentos de ID, picos súbitos de volume após criação da conta e conexões inexplicadas a carteiras previamente vinculadas a golpes. Para iniciantes, isso importa porque mesmo plataformas legítimas podem ser abusadas em segundo plano, e exchanges agora dependem de análise blockchain para congelar ou rastrear fundos antes que desapareçam.

8. Botnets Sociais no X (Twitter)

Golpistas cripto operam botnets massivos no X que parecem humanos, respondem a posts instantaneamente e empurram links de dreno de carteira ou airdrops falsos. Segundo analistas de segurança citados pela Chainalysis e mídia da indústria, a IA torna esses bots mais difíceis de detectar, sem texto repetido, melhor gramática, gírias localizadas, até respostas personalizadas. Uma tática comum chamada "responder-e-bloquear" faz bots responderem a usuários reais (aumentando sinais de engajamento), então os bloqueiam, o que pode reduzir a visibilidade da vítima enquanto amplifica posts de golpe.

Essas redes frequentemente personificam fundadores, influenciadores ou suporte de exchange, então iscam usuários para assinar contratos inteligentes maliciosos. Como usuários cripto dependem do X para notícias em tempo real, os bots exploram urgência e medo de perder oportunidades. Para iniciantes: nunca confie em links em respostas, especialmente se prometem tokens grátis, retornos garantidos ou exigem aprovações de carteira; a maioria dos "sorteios" de alto perfil no X são golpes.

Como Se Defender de Golpes de IA

Golpes de IA estão ficando mais inteligentes, mas você pode ficar um passo à frente. Siga essas dicas para proteger sua cripto e paz de espírito.

1. Ative 2FA, Chaves de Acesso ou uma Chave de Hardware: Autenticação de dois fatores (2FA) bloqueia a maioria das tentativas de apropriação de conta porque golpistas precisam de mais que sua senha. Estudos de cibersegurança como o Relatório de Segurança do Google mostram que violações de conta caem mais de 90% quando 2FA baseado em hardware é habilitado. Se sua plataforma suporta

Chaves de acesso, ative-as; elas substituem senhas inteiramente com um login criptográfico vinculado ao seu dispositivo, tornando ataques de phishing quase inúteis porque não há senha para roubar. Ferramentas como

Google Authenticator, Chaves de Acesso integradas no iOS/Android ou uma YubiKey tornam quase impossível para atacantes fazerem login, mesmo se enganarem você com e-mails de phishing gerados por IA. Sempre ative 2FA ou Chaves de Acesso na BingX, e-mail, exchanges e carteiras que as suportam.

2. Verifique Links e URLs Cuidadosamente: Uma grande parte dos golpes de IA começa com um link falso. A Chainalysis observa que sites de phishing gerados por IA são um dos vetores de golpe de crescimento mais rápido porque parecem quase idênticos a plataformas reais. Antes de clicar, passe o mouse para visualizar a URL e certifique-se de que corresponde ao domínio oficial da BingX. Marque a página de login nos favoritos e evite links enviados por e-mail, Telegram, Discord ou respostas do Twitter; golpistas frequentemente falsificam contas de suporte ou páginas de airdrop para roubar logins e informações de carteira.

3. Seja Cético de Qualquer Coisa Que Pareça Boa Demais: Se um bot afirma "retornos garantidos", "renda sem risco" ou "dobre sua cripto", é um golpe. Trading real, mesmo com IA, nunca garante lucro. A Chainalysis relatou que plataformas de trading falsas e "bots de sinal de IA" roubaram bilhões em 2024-25 prometendo retornos que nenhum sistema real pode entregar. Se algo soa bom demais para ser verdade em cripto, sempre é.

4. Nunca Compartilhe Frases de Recuperação ou Chaves Privadas: Sua frase de recuperação controla sua carteira. Qualquer um que peça por ela está tentando roubar sua cripto. Nenhuma exchange legítima, projeto ou equipe de suporte irá solicitá-la, nem uma vez. Muitos golpes de phishing impulsionados por IA agora pedem aos usuários para "verificar" sua carteira ou "desbloquear recompensas de bônus" usando uma frase de recuperação. No momento em que você a digita em um site falso, seus ativos se foram. Trate sua frase de recuperação como sua identidade digital: privada, offline e nunca compartilhada.

5. Use Suporte Oficial da BingX Apenas: Golpistas frequentemente personificam agentes de suporte de exchange através de e-mail ou mídia social. Eles afirmarão que há um problema com sua retirada ou oferecerão "assistência" para corrigir um problema de conta — então enviam um link malicioso. Sempre acesse suporte através do site ou aplicativo oficial da BingX. Se alguém te contactar primeiro, assuma que é um golpe. Elliptic e TRM Labs observam que ataques de imitação dispararam à medida que ferramentas de IA tornam contas falsas mais difíceis de distinguir das reais.

6. Armazene Cripto de Longo Prazo em uma Carteira de Hardware: Carteiras de hardware como Ledger e Trezor mantêm suas chaves privadas offline, o que protege seus fundos mesmo se você cair em um link de phishing ou ataque de malware. Como o dispositivo deve aprovar fisicamente cada transação, golpistas não podem roubar sua cripto remotamente. Pesquisas de múltiplas auditorias de segurança cripto mostram que armazenamento frio permanece o método mais eficaz para proteger participações de longo prazo, especialmente quando mercados são alvo de drenos de carteira impulsionados por IA.

7. Mantenha-se Informado com Recursos de Aprendizagem da BingX: Golpes de IA evoluem rapidamente, e se manter educado é uma das defesas mais fortes. A TRM Labs encontrou um aumento de 456% em golpes habilitados por IA ano a ano, o que significa que novas táticas aparecem constantemente. Ler guias de segurança confiáveis, alertas de golpes e avisos de phishing ajuda você a detectar sinais de alerta antes de se tornar uma vítima. A

Academia BingX publica regularmente dicas de segurança amigáveis para iniciantes para que usuários possam negociar com confiança mesmo em um ambiente em rápida mudança.

Conclusão e Principais Pontos

Golpes cripto alimentados por IA estão se espalhando porque são baratos, escaláveis e convincentes, mas você ainda pode se manter seguro. Ative 2FA, evite clicar em links não verificados, armazene fundos de longo prazo em uma carteira de hardware e nunca compartilhe sua frase de recuperação. Se alguém prometer lucros garantidos ou enviar um link suspeito, vá embora. E à medida que golpistas evoluem, sua melhor defesa é conhecimento. Siga a Academia BingX para dicas de segurança contínuas, alertas de golpes e educação de segurança cripto para que você possa proteger seus ativos na era da IA.

Leitura Relacionada