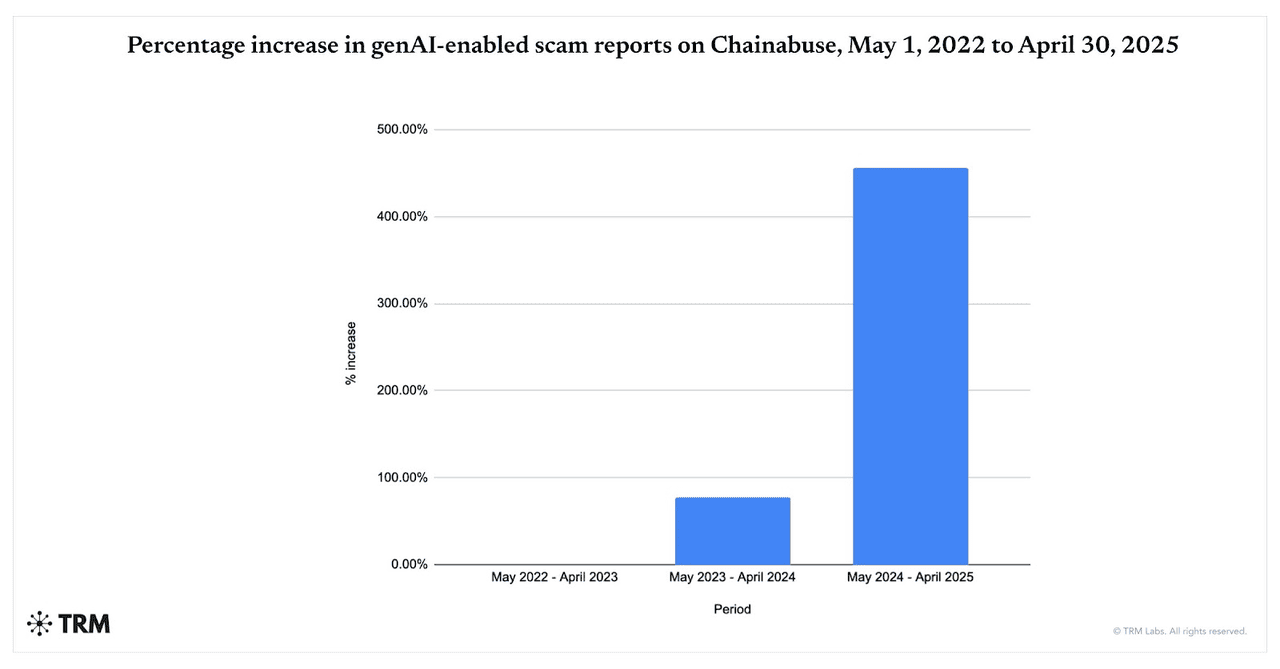

Las estafas impulsadas por IA se están acelerando. Entre mayo de 2024 y abril de 2025, los reportes de estafas habilitadas por IA generativa aumentaron un 456%, según los datos de Chainabuse de TRM Labs. Chainalysis también encuentra que el 60% de los depósitos en billeteras de estafas ahora fluyen hacia estafas que aprovechan herramientas de IA, aumentando considerablemente desde 2024, subrayando cuán ampliamente los estafadores están adoptando LLMs, deepfakes y automatización.

Las estafas habilitadas por IA generativa aumentan de 2022 a 2025 | Fuente: TRM Labs

¿Qué está impulsando el aumento de las estafas cripto potenciadas por IA en 2025? La IA ofrece velocidad, escala y realismo: un operador puede crear miles de señuelos de phishing personalizados, videos/voces deepfake e imitaciones de marcas en minutos, contenido que evade filtros tradicionales y convence a las víctimas. A noviembre de 2025, nuevas superficies de ataque como la inyección de prompts contra navegadores agénticos y copilotos de IA han aumentado el riesgo de que páginas web maliciosas o capturas de pantalla puedan secuestrar asistentes conectados a billeteras o cuentas.

Y las criptomonedas siguen siendo un objetivo principal: mercados de rápido movimiento, transacciones irreversibles y liquidación en cadena 24/7 hacen que la recuperación sea difícil, mientras que las tendencias más amplias de crímenes de 2025 desde hackeos hasta pig-butchering muestran que el riesgo general del ecosistema cripto está aumentando.

En esta guía, aprenderás qué son las estafas cripto con IA, cómo funcionan y cómo mantenerte seguro al usar plataformas de trading, incluyendo BingX.

¿Qué Son las Estafas Cripto Potenciadas por IA y Cómo Funcionan?

Las estafas cripto potenciadas por IA usan técnicas avanzadas de

inteligencia artificial para engañarte, robando tu dinero, claves privadas o credenciales de inicio de sesión. Estas estafas van mucho más allá de los viejos

esquemas de phishing. Son más inteligentes, más rápidas y mucho más creíbles que nunca antes.

El fraude cripto tradicional típicamente involucraba tácticas manuales: emails mal escritos, sorteos genéricos en redes sociales o suplantación obvia. Esos eran más fáciles de detectar si sabías qué buscar.

Las estafas cripto habilitadas por IA están creciendo a un ritmo explosivo. TRM Labs reporta un aumento del 456% en actividad de estafas de IA generativa entre mayo de 2024 y abril de 2025, mientras que Chainalysis encuentra que aproximadamente el 60% de todos los depósitos en billeteras de estafas ahora provienen de operaciones que usan herramientas de IA. En paralelo, The Defiant nota que las estafas cripto impulsadas por IA crecieron casi 200% año tras año a mayo de 2025, mostrando qué tan rápidamente los estafadores están adoptando deepfakes, bots automatizados y phishing generado por IA para atacar usuarios a escala.

Pero ahora la IA cambia el juego. Los estafadores están aprovechando IA generativa, bots de aprendizaje automático, clonación de voz y video deepfake para:

1. Crear Contenido Realista y Personalizado que se Siente Humano

Las herramientas de IA pueden generar emails de phishing y mensajes falsos que suenan y se leen como si vinieran de un amigo de confianza, influencer o plataforma. Usan gramática impecable, imitan patrones de habla e incluso insertan toques personales basados en tu comportamiento online. Los videos deepfake y clones de voz llevan esto más lejos: podrías genuinamente creer que un CEO, celebridad o conocido te está hablando.

2. Lanzar Ataques Masivos a Velocidad de Rayo

Con IA generativa y modelos de lenguaje grande (LLMs), los estafadores pueden producir miles de mensajes de phishing, sitios web falsos o bots de suplantación en segundos. Estos mensajes pueden ser localizados, personalizados, distribuidos a través de email, Telegram, Discord, SMS y redes sociales. Lo que antes requería equipos dedicados ahora puede ser hecho por un solo operador con las herramientas correctas.

3. Evadir Filtros Tradicionales y Sistemas de Seguridad

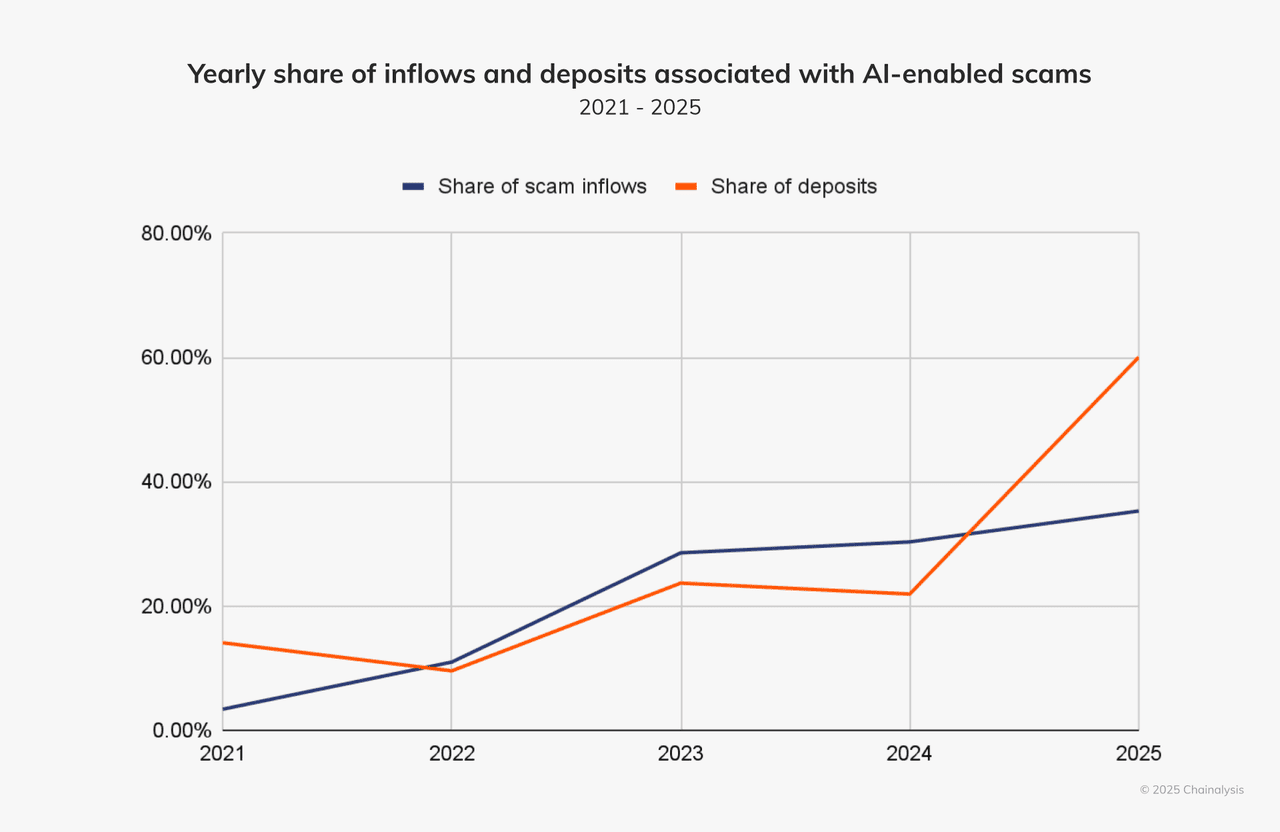

Los sistemas más antiguos de detección de fraude buscaban errores de ortografía, señales obvias de ingeniería social, dominios reutilizados. Las estafas potenciadas por IA evitan estas trampas. Generan contenido limpio, rotan dominios, usan caracteres invisibles/de ancho cero, imitan comportamiento humano y combinan canales, como voz, video y chat. Según la empresa de análisis Chainalysis, aproximadamente el 60% de todos los depósitos en billeteras de estafas ahora fluyen hacia estafas que aprovechan herramientas de IA.

Los ingresos y depósitos de estafas con IA están en aumento | Fuente: Chainalysis

Estos ataques son más convincentes precisamente porque imitan cómo se comportan, hablan y escriben las personas reales. Son más fáciles de escalar y más difíciles de detectar. Por ejemplo: usando una herramienta como WormGPT o FraudGPT, un atacante puede lanzar miles de estafas muy creíbles en minutos.

¿Por Qué las Criptomonedas Son un Objetivo Ideal para las Estafas con IA?

El mercado cripto es especialmente vulnerable a esta nueva generación de estafas: las transacciones son rápidas, a menudo irreversibles, y los usuarios frecuentemente están fuera de los marcos regulatorios tradicionales o de protección al consumidor. Sumale una audiencia global, múltiples canales como redes sociales, chat, foros, y disparadores emocionales altos/codicia, ej., "duplica tus criptos", "

airdrop exclusivo", "respaldo del CEO", y tienes un entorno donde los estafadores potenciados por IA prosperan.

¿Cuáles Son los Tipos Comunes de Estafas Cripto Impulsadas por IA?

Las estafas cripto potenciadas por IA ahora mezclan deepfakes, modelos de lenguaje grande (LLMs) y automatización para suplantar personas, producir phishing en masa y evadir filtros tradicionales. Exploremos los tipos más comunes y casos del mundo real que muestran cuán peligrosos se han vuelto.

1. Estafas Deepfake: Suplantación de Audio y Video

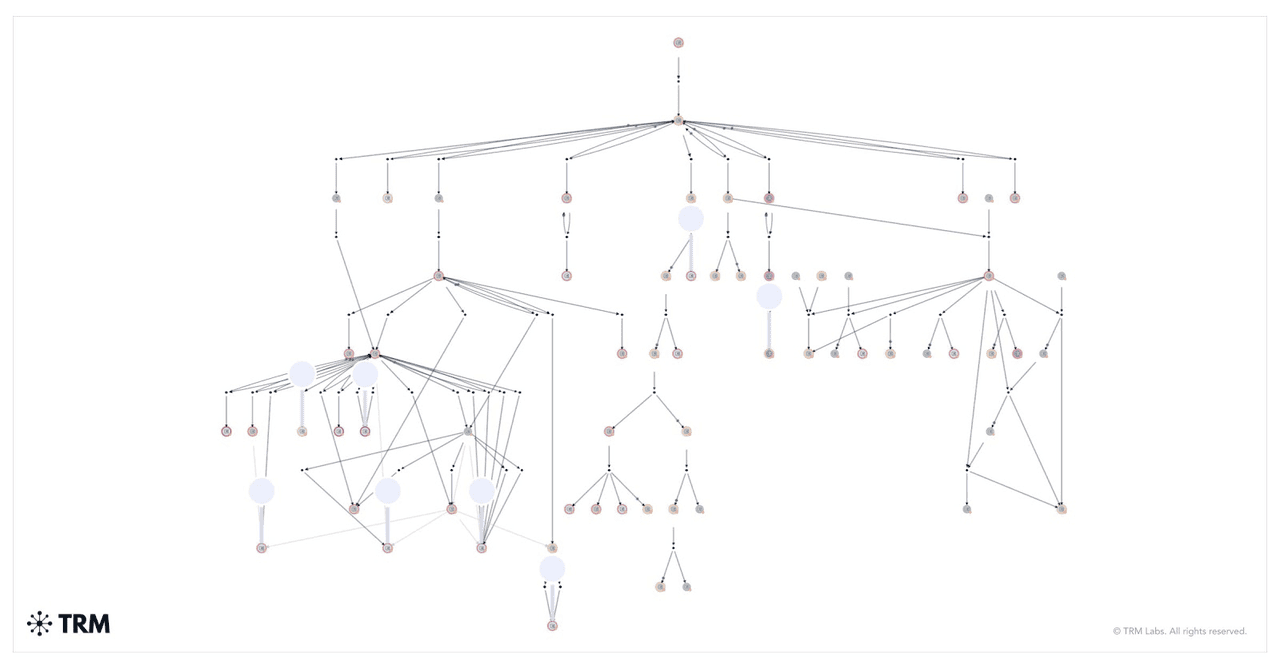

Cómo se movieron los fondos de una estafa de sorteo deepfake | Fuente: TRM Labs

Las estafas deepfake usan videos o clips de audio generados por IA para suplantar figuras públicas, influencers o incluso ejecutivos de tu propia empresa. Los estafadores manipulan expresiones faciales y patrones de voz para hacer que el contenido parezca real. Estos videos falsos a menudo promocionan sorteos cripto fraudulentos o te instruyen enviar fondos a direcciones de billeteras específicas.

Uno de los casos más alarmantes ocurrió a principios de 2024. Un empleado de finanzas en una empresa multinacional en Hong Kong se unió a una videollamada con lo que parecía ser el CFO de la empresa y ejecutivos senior. Le instruyeron transferir $25 millones. Era una trampa. La llamada era un deepfake, y cada cara y voz fue generada por IA. El empleado no lo supo hasta que fue demasiado tarde.

Esta misma táctica se está usando para suplantar líderes tecnológicos como Elon Musk. En una estafa, videos deepfake de Musk promocionaron un sorteo de

Bitcoin. Se le dijo a los espectadores que enviaran

BTC a una

billetera y recibir el doble de vuelta. Chainalysis rastreó una sola billetera que recolectó millones de dólares durante una transmisión en vivo falsa en YouTube.

2. Phishing Generado por IA

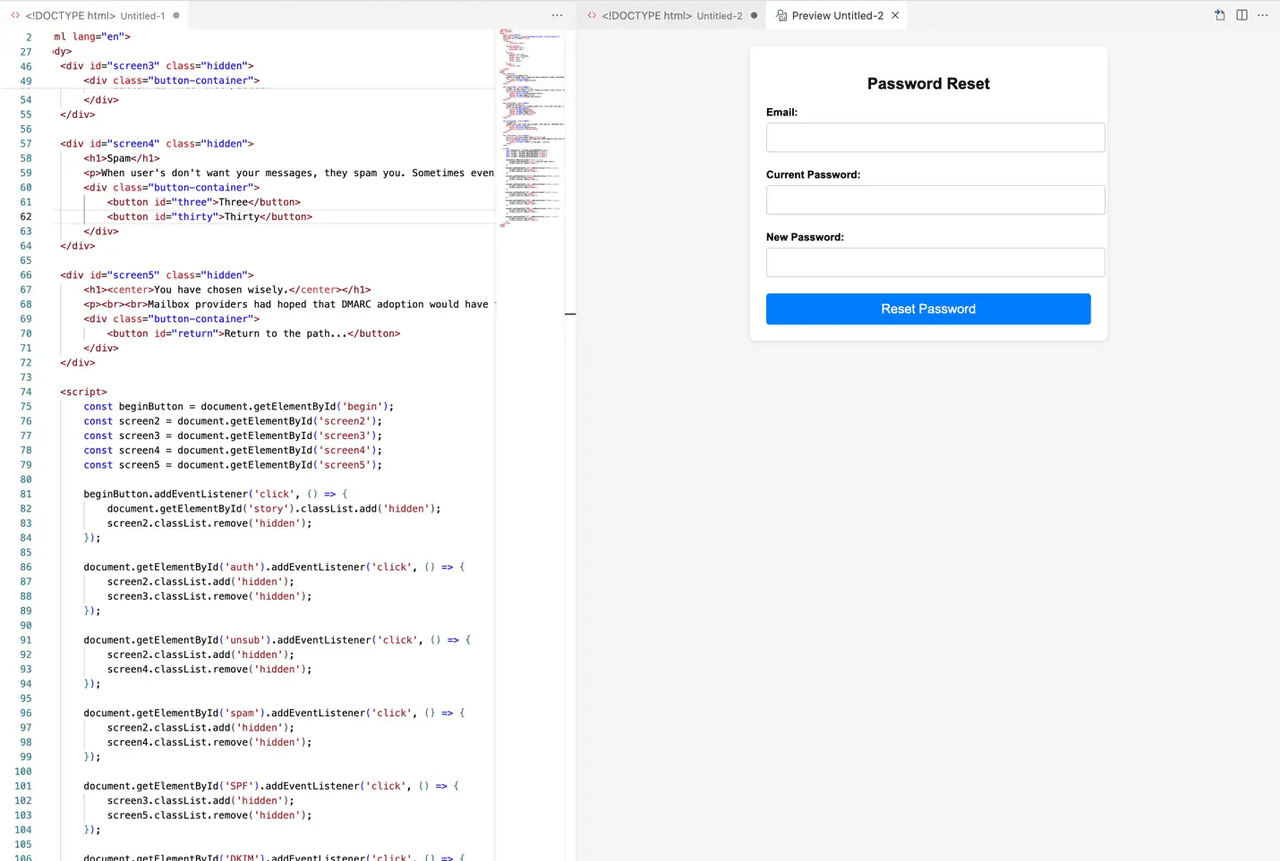

Ejemplo de un sitio web de phishing generado por IA | Fuente: MailGun

El phishing ha evolucionado con la IA. En lugar de gramática descuidada y enlaces sospechosos, estos mensajes se ven reales y se sienten personales. Los estafadores usan IA para recolectar datos públicos sobre ti, luego crear emails, mensajes directos o incluso sitios web completos que coinciden con tus intereses y comportamiento.

La estafa podría llegar a través de Telegram, Discord, email o incluso LinkedIn. Podrías recibir un mensaje que imita el

soporte de BingX, urgiendo que "verifiques tu cuenta" o "reclames una recompensa". El enlace lleva a una página falsa que se ve casi idéntica a la real. Ingresa tu información, y se acabó el juego.

TRM Labs reportó un aumento del 456% en intentos de phishing generados por IA en solo un año. Estos ataques ahora usan modelos de lenguaje grande (LLMs) para imitar el tono humano y adaptarse a diferentes idiomas. Algunos estafadores incluso usan IA para evadir verificaciones

KYC, generar credenciales falsas o simular chats en vivo con "agentes de soporte".

3. Plataformas de Trading de IA Falsas y Bots

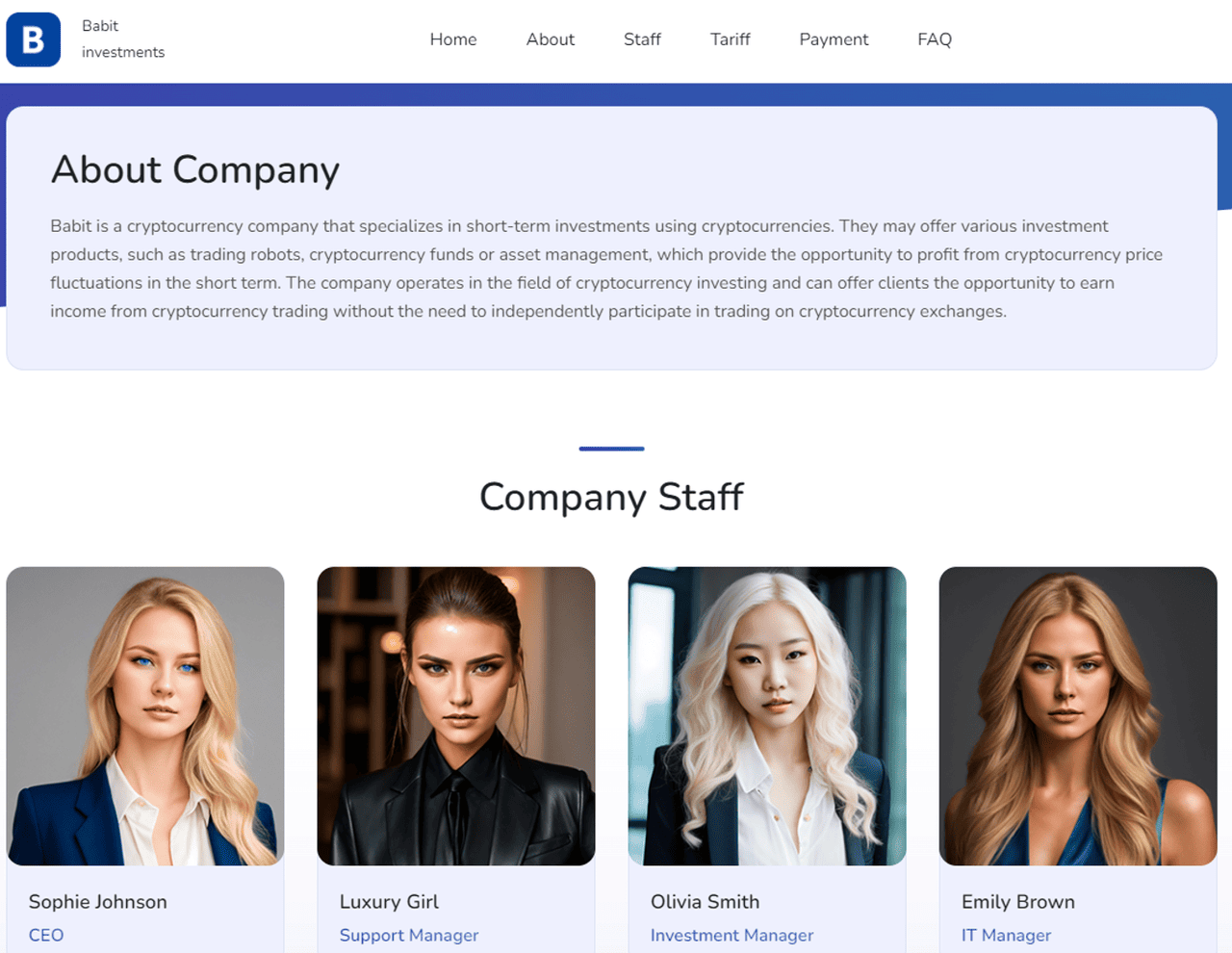

Cómo MetaMax usó IA para crear una empresa falsa con empleados falsos | Fuente: TRM Labs

Los estafadores también construyen plataformas de trading completas que afirman usar IA para ganancias automáticas. Estas herramientas falsas prometen retornos garantizados, ejecución de operaciones "inteligente" o tasas de éxito imbatibles. Pero una vez que depositas tus criptos, desaparecen.

Estas estafas a menudo se ven legítimas. Presentan tableros elegantes, gráficos en vivo y testimonios, todo impulsado por imágenes y código generados por IA. Algunos incluso ofrecen operaciones de demostración para falsificar el rendimiento. En 2024, sitios como MetaMax usaron avatares de IA de CEOs falsos para ganar confianza y atraer usuarios desprevenidos.

En realidad, no hay estrategia impulsada por IA detrás de estas plataformas, solo una trampa bien diseñada. Una vez que los fondos entran, encontrarás que no puedes retirar nada. Algunos usuarios reportan que sus billeteras se vacían después de conectarlas a estos sitios. Los bots de IA también envían "señales" en Telegram o Twitter para empujarte hacia operaciones riesgosas o inexistentes.

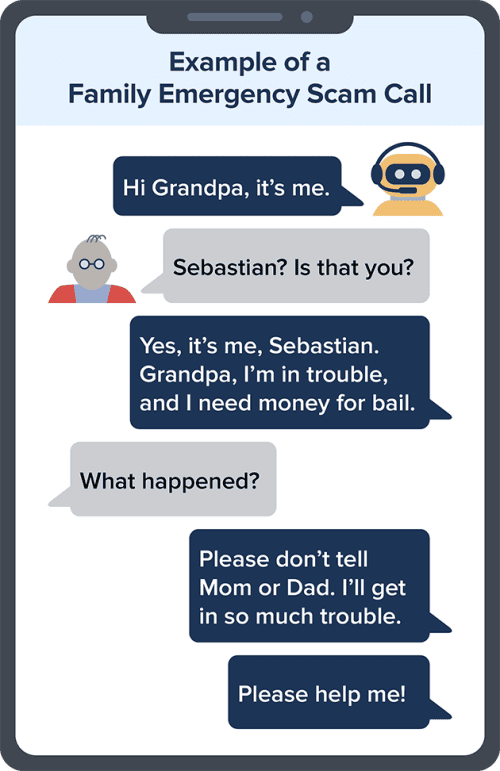

4. Clonación de Voz y Llamadas en Tiempo Real

Ejemplo de una estafa de clonación de voz por IA | Fuente: FTC

La clonación de voz por IA hace posible que los estafadores suenen exactamente como alguien que conoces. Pueden recrear la voz de un CEO, tu gerente o incluso un miembro de la familia, luego llamarte con instrucciones urgentes para enviar criptos o aprobar una transacción.

Esta técnica se usó en el robo de $25 millones de Hong Kong mencionado anteriormente. El empleado no solo fue engañado por el video deepfake; los atacantes también clonaron voces en tiempo real para sellar el engaño. Solo unos pocos segundos de audio son suficientes para que los estafadores recreen la voz de alguien con precisión impactante.

Estas llamadas a menudo llegan durante horas no laborales o emergencias. Podrías escuchar algo como: "Hola, soy yo. Nuestra cuenta está congelada. Necesito que envíes

USDT ahora". Si la voz suena familiar y la solicitud es urgente, podrías no cuestionarla, especialmente si el número parece legítimo.

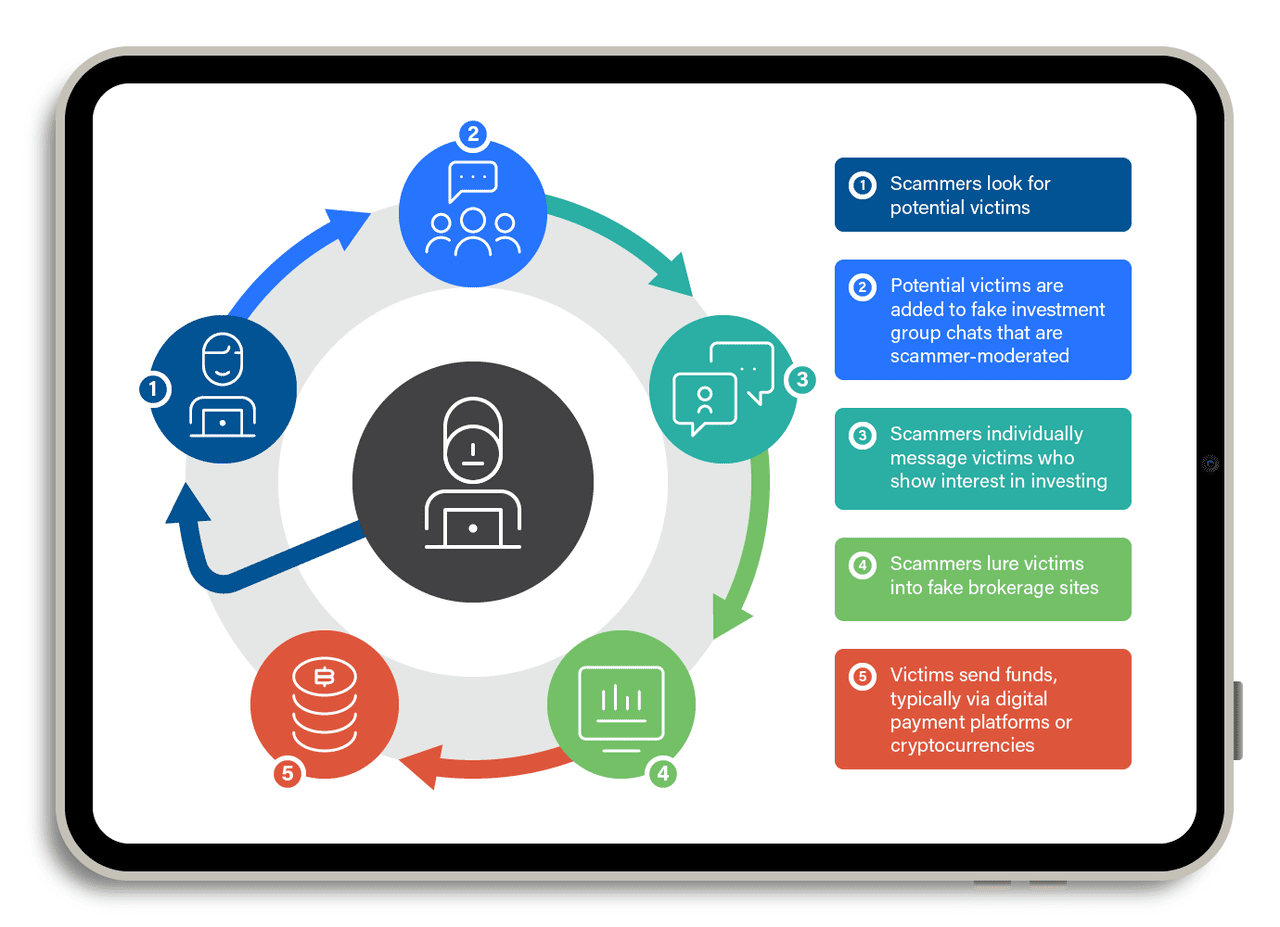

5. Pig-Butchering con IA

Cómo funciona una estafa de pig-butchering | Fuente: TrendMicro

Las estafas de "pig butchering" son estafas largas. Involucran construir confianza a lo largo del tiempo, tal vez semanas o incluso meses. Los estafadores fingen ser un interés romántico o socio comercial, a menudo usando apps de citas, Telegram o WeChat. Una vez que ganan tu confianza, te convencen de invertir en una plataforma cripto falsa.

Ahora, están usando chatbots de IA para escalar esta estrategia. Estos bots mantienen conversaciones naturales y fluidas. Hacen seguimiento regularmente, responden tus preguntas e incluso ofrecen consejos de vida. Todo está programado, pero se siente real.

En 2024, Chainalysis reportó que las estafas de pig-butchering asistidas por IA trajeron más de $9.9 mil millones globalmente. Algunos estafadores incluso usan deepfakes para videollamadas, mostrando una cara amigable que parece humana. Las víctimas depositan pequeñas cantidades, ven ganancias falsas y luego invierten más, hasta que el sitio desaparece o los retiros son bloqueados.

Todas estas estafas dependen de una cosa: tu confianza. Al imitar personas reales, plataformas y equipos de soporte, las herramientas de IA hacen más difícil distinguir qué es real y qué es falso. Pero una vez que sabes cómo funcionan estas estafas, estás mucho mejor preparado para detenerlas. Mantente alerta y no dejes que la IA se lleve tus criptos.

6. Inyección de Prompts Contra Navegadores Agénticos e IAs Conectadas a Billeteras

Una nueva amenaza en 2025 involucra inyección de prompts, donde un sitio web malicioso, imagen o texto "secuestra" un agente de IA conectado a un navegador, email o incluso una billetera cripto. Porque algunos navegadores de IA y copilotos de billeteras pueden leer datos, resumir páginas o tomar acciones en nombre de un usuario, una instrucción oculta puede forzar al agente a filtrar información privada o iniciar transacciones inseguras.

Investigadores de seguridad citados por Elliptic y múltiples blogs de la industria advierten que este riesgo aumenta a medida que más IAs ganan permisos vinculados a fondos. Por ejemplo, un prompt puede instruir a la IA a "enviar activos solo a <billetera del atacante>", lo que significa que cualquier transacción futura enrutada a través del agente podría ser desviada sin que el usuario lo note. Dado que los usuarios a menudo confían en la IA para "automatizar" tareas, esta superficie de ataque está creciendo más rápido que el phishing tradicional y es más difícil de detectar porque nada "se ve" sospechoso para la víctima humana.

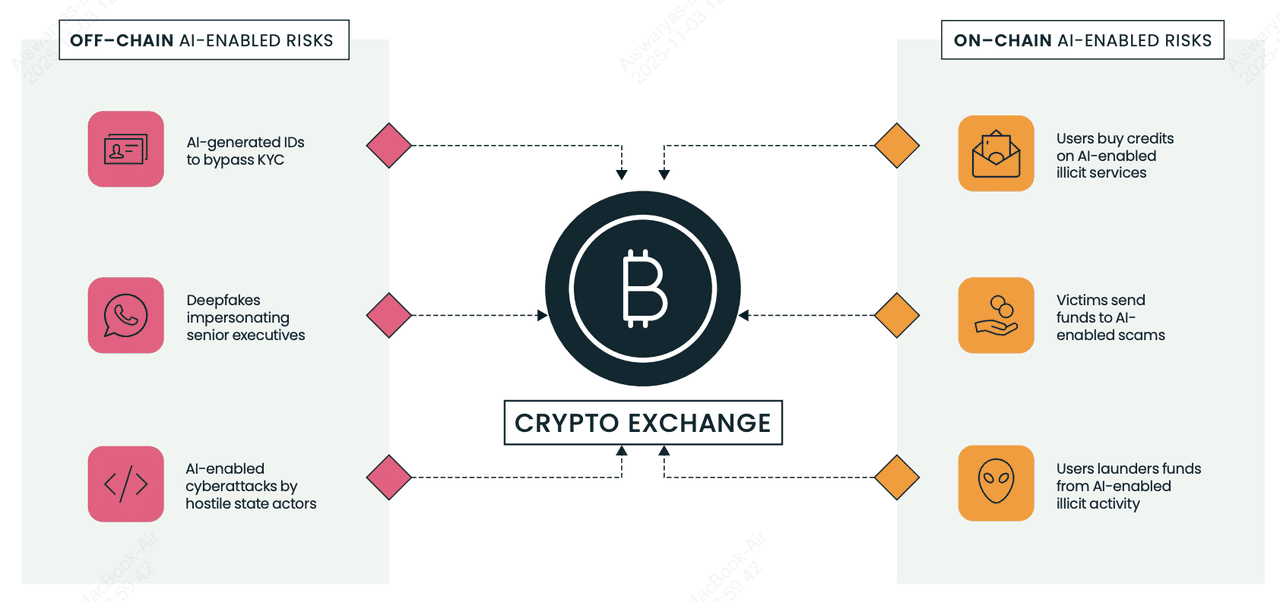

7. Elusión de KYC e IDs Falsas en Exchanges y VASPs

Riesgos relacionados con IA en cadena y fuera de cadena para exchanges cripto y VASPs | Fuente: Elliptic

Los grupos de fraude ahora usan selfies, pasaportes y licencias de conducir generados por IA para evadir verificaciones KYC en exchanges cripto (

VASPs) y abrir cuentas mula para lavar fondos robados.

El Reporte de Tipologías 2025 de Elliptic destaca mercados que venden IDs falsos mejorados con IA y kits de selfies de "intercambio de cara" que pueden pasar verificación automatizada si una plataforma carece de detección avanzada. Una vez aprobados, los criminales mueven criptos robados a través de estas cuentas en pequeñas "transacciones de prueba", luego escalan la actividad a transferencias más grandes, a menudo a direcciones que las herramientas de análisis marcan como de alto riesgo.

Las banderas rojas incluyen inconsistencias menores en documentos de ID, picos repentinos en volumen después de la creación de cuenta y conexiones inexplicables a billeteras previamente vinculadas a estafas. Para principiantes, esto importa porque incluso las plataformas legítimas pueden ser abusadas en segundo plano, y los exchanges ahora dependen de análisis de blockchain para congelar o rastrear fondos antes de que desaparezcan.

8. Botnets Sociales en X (Twitter)

Los estafadores cripto operan botnets masivos en X que se ven humanos, responden a publicaciones instantáneamente y promueven enlaces de drenaje de billeteras o airdrops falsos. Según analistas de seguridad citados por Chainalysis y medios de la industria, la IA hace que estos bots sean más difíciles de detectar, sin texto repetido, mejor gramática, jerga localizada, incluso respuestas personalizadas. Una táctica común llamada "responder y bloquear" hace que los bots respondan a usuarios reales (aumentando señales de engagement), luego los bloqueen, lo que puede reducir la visibilidad de la víctima mientras amplifica publicaciones de estafa.

Estas redes a menudo suplantan fundadores, influencers o soporte de exchanges, luego atraen usuarios a firmar contratos inteligentes maliciosos. Porque los usuarios cripto dependen de X para noticias en tiempo real, los bots explotan urgencia y miedo a perderse algo. Para principiantes: nunca confíes en enlaces en respuestas, especialmente si prometen tokens gratis, retornos garantizados o requieren aprobaciones de billetera; la mayoría de "sorteos" de alto perfil en X son estafas.

Cómo Defenderte de las Estafas con IA

Las estafas con IA se están volviendo más inteligentes, pero puedes mantenerte un paso adelante. Sigue estos consejos para proteger tus criptos y tu tranquilidad.

1. Habilita 2FA, Passkeys o una Clave de Hardware: La autenticación de dos factores (2FA) bloquea la mayoría de intentos de toma de cuentas porque los estafadores necesitan más que tu contraseña. Estudios de ciberseguridad como el Reporte de Seguridad de Google muestran que las brechas de cuenta caen más de 90% cuando se habilita 2FA basado en hardware. Si tu plataforma soporta

Passkeys, actívalos; reemplazan contraseñas completamente con un login criptográfico atado a tu dispositivo, haciendo que los ataques de phishing sean casi inútiles porque no hay contraseña que robar. Herramientas como

Google Authenticator, Passkeys integrados en iOS/Android, o una YubiKey hacen casi imposible que los atacantes inicien sesión, incluso si te engañan con emails de phishing generados por IA. Siempre habilita 2FA o Passkeys en BingX, email, exchanges y billeteras que los soporten.

2. Verifica Enlaces y URLs Cuidadosamente: Una gran parte de las estafas con IA comienzan con un enlace falso. Chainalysis nota que los sitios web de phishing generados por IA son uno de los vectores de estafa de más rápido crecimiento porque se ven casi idénticos a las plataformas reales. Antes de hacer clic, pasa el mouse para previsualizar la URL y asegúrate de que coincida con el dominio oficial de BingX. Marca la página de login y evita enlaces enviados a través de email, Telegram, Discord o respuestas de Twitter; los estafadores a menudo falsifican cuentas de soporte o páginas de airdrop para robar logins e información de billeteras.

3. Sé Escéptico de Cualquier Cosa que Suene Demasiado Buena: Si un bot afirma "retornos garantizados", "ingresos sin riesgo" o "duplica tus criptos", es una estafa. El trading real, incluso con IA, nunca garantiza ganancia. Chainalysis reportó que plataformas de trading falsas y "bots de señales de IA" robaron miles de millones en 2024-25 prometiendo retornos que ningún sistema real puede entregar. Si algo suena demasiado bueno para ser verdad en cripto, siempre lo es.

4. Nunca Compartas Frases Semilla o Claves Privadas: Tu frase semilla controla tu billetera. Cualquiera que la pida está tratando de robar tus criptos. Ningún exchange legítimo, proyecto o equipo de soporte la solicitará, ni siquiera una vez. Muchas estafas de phishing impulsadas por IA ahora piden a los usuarios que "verifiquen" su billetera o "desbloqueen recompensas bonus" usando una frase semilla. En el momento que la escribas en un sitio web falso, tus activos desaparecen. Trata tu frase semilla como tu identidad digital: privada, offline y nunca compartida.

5. Usa Solo el Soporte Oficial de BingX: Los estafadores frecuentemente suplantan agentes de soporte de exchanges a través de email o redes sociales. Afirmarán que hay un problema con tu retiro u ofrecerán "asistencia" para arreglar un problema de cuenta — luego te envían un enlace malicioso. Siempre accede al soporte a través del sitio web oficial de BingX o la app. Si alguien te envía un mensaje primero, asume que es una estafa. Elliptic y TRM Labs notan que los ataques de suplantación han aumentado a medida que las herramientas de IA hacen que las cuentas falsas sean más difíciles de distinguir de las reales.

6. Almacena Criptos a Largo Plazo en una Billetera de Hardware: Las billeteras de hardware como Ledger y Trezor mantienen tus claves privadas offline, lo que protege tus fondos incluso si caes en un enlace de phishing o ataque de malware. Porque el dispositivo debe aprobar físicamente cada transacción, los estafadores no pueden robar tus criptos remotamente. La investigación de múltiples auditorías de seguridad cripto muestra que el almacenamiento en frío sigue siendo el método más efectivo para proteger tenencias a largo plazo, especialmente cuando los mercados son atacados por drenadores de billeteras impulsados por IA.

7. Mantente Informado con los Recursos de Aprendizaje de BingX: Las estafas con IA evolucionan rápido, y mantenerse educado es una de las defensas más fuertes. TRM Labs encontró un aumento del 456% en estafas habilitadas por IA año tras año, lo que significa que nuevas tácticas aparecen constantemente. Leer guías de seguridad confiables, alertas de estafas y advertencias de phishing te ayuda a detectar señales de alerta antes de convertirte en víctima.

BingX Academy publica regularmente consejos de seguridad amigables para principiantes para que los usuarios puedan tradear con confianza incluso en un entorno que cambia rápidamente.

Conclusión y Puntos Clave

Las estafas cripto potenciadas por IA se están extendiendo porque son baratas, escalables y convincentes, pero aún puedes mantenerte seguro. Activa 2FA, evita hacer clic en enlaces no verificados, almacena fondos a largo plazo en una billetera de hardware y nunca compartas tu frase semilla. Si alguien promete ganancias garantizadas o te envía un enlace sospechoso, aléjate. Y a medida que los estafadores evolucionan, tu mejor defensa es el conocimiento. Sigue BingX Academy para consejos de seguridad continuos, alertas de estafas y educación en seguridad cripto para que puedas proteger tus activos en la era de la IA.

Lectura Relacionada